2023年11月6日にOpenAIはDevDayを開催しし、大規模言語モデルのGPT-4とGPT-3.5にさらなる改善を加えたと発表しました。

新しいモデルの名称は、「GTP-4Turbo」です。

2023年の3月に発表された「GPT-4」の発表からわずか半年で新しいモデルが発表されました。

知識ベースのアップデートと、はるかに長いコンテキストウィンドウの採用が含まれています。

GoogleやMicrosoftに続き、顧客を著作権訴訟から保護する方針も明らかにしました。

現在APIプレビューを通じて利用可能なGPT-4 Turboは、2023年4月までの情報を学習済みだと発表されました。

3月にリリースされたGPT-4の初期バージョンは、2021年9月までのデータしか学習していませんでしたので、

そこからおおよそ1年半分のデータがアップデートされたことはとても大きな違いです。

OpenAIは数週間以内に本番レベルのTurboモデルをリリースする予定ですが、正確な日程は示されませんでした。

この記事では、OpenAIによる「DevDay」キーノートにおいて、新発表された内容を詳細に解説していきます。

- GPT-4Turboの特徴

- GPT-4Turboおよび以前のモデルの新価格体系

- GPTs:ChatGPTをカスタマイズ可能

- GPTsのストア

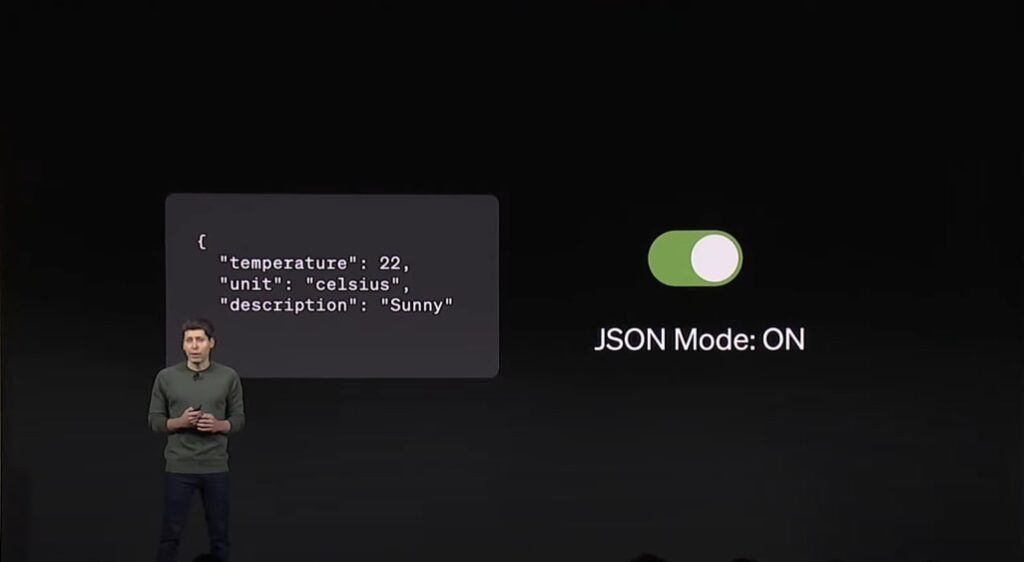

- JSONモード

- シード値の指定

- マルチモーダルAPI

- 新API:アシスタントAPI

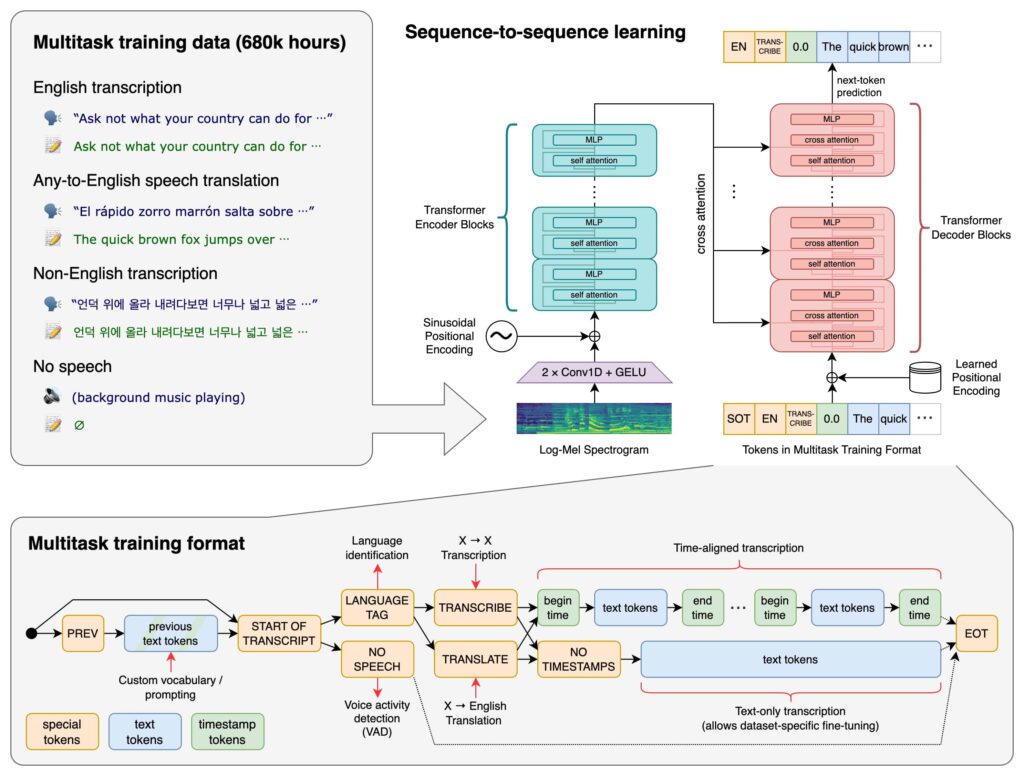

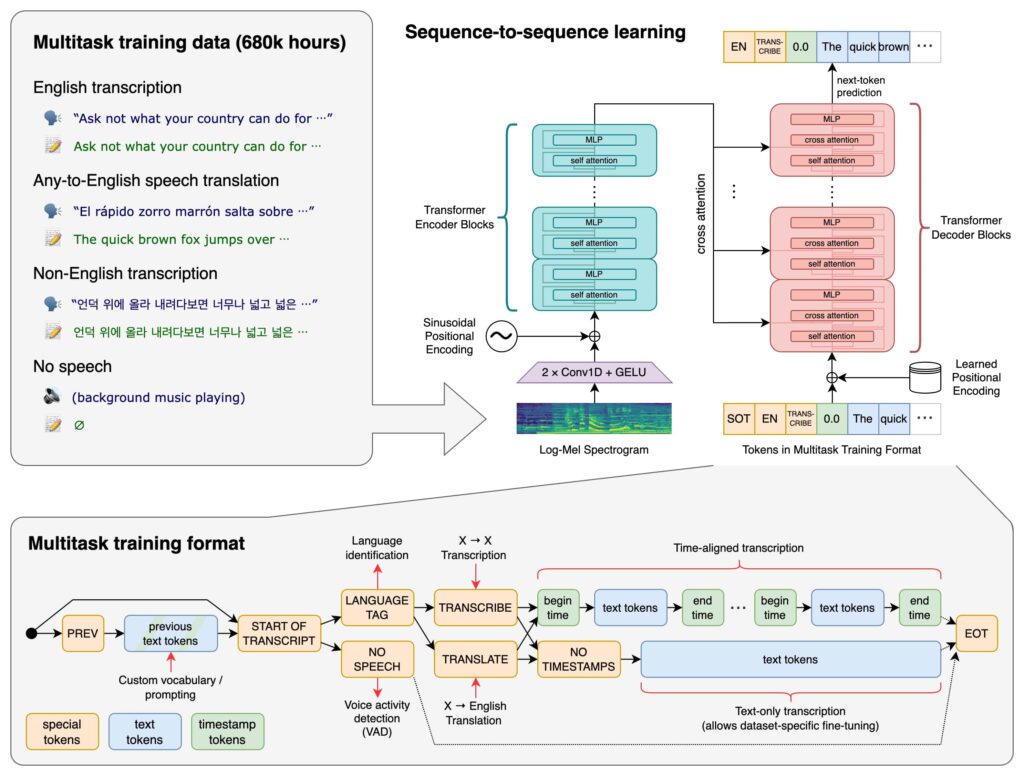

- Be My EyesとWhisper V3

ミラ

ミラGPT4の発表からまだ半年しか経っていないのにもう新しいモデルが発表されるなんで、本当にペースが早くてびっくり!

そうだよね!GPTモデルは、初代モデルからずっと半年〜2年おきごとに進化してきているんだ。それぞれのバージョンで何倍も進化しているんだ。

OpenAIによる革新的な新発表

OpenAI DevDay初回デベロッパー向けカンファレンス

OpenAI DevDayは、AI技術の最前線に立つイベントとして、その革新性と将来のビジョンを示す場となりました。

GPT-4 Turboを始め、今後多くの企業や開発者、そしてユーザーを含む社会全体に影響を及ぼしうる内容でした。

発表の流れと内容の概要一覧(長いので興味がある方は開いてください)

2022年12月ChatGPTがロンチされ、今までない勢いで広がりました。

2023年3月には、GPT-4が発表され大言語モデルとしてト世界トップレベルのパフォーマンスを出しています。

2023年9月末には、ボイス機能や画像機能のGPT-4Visionが追加され追加され、ChatGPTは、「見る」

「聞く」「話す」ことができるようになりました。

そして2023年10月には、画像生成AIであるDALL-E3がChatGPTに追加されました。

一般向け有料プランのChatGPT Plusプランより高速で無制限のGPT-4へのアクセスだけでなく、

より多くの文字のインプット、アウトプットが可能である最大32kのトークン(Plusプランの最大8kの4倍)になっています。

多くの企業が懸念していた安全性とプライバシーを強化し、EntepriseモデルやAPIからのデータを学習させないとしています。

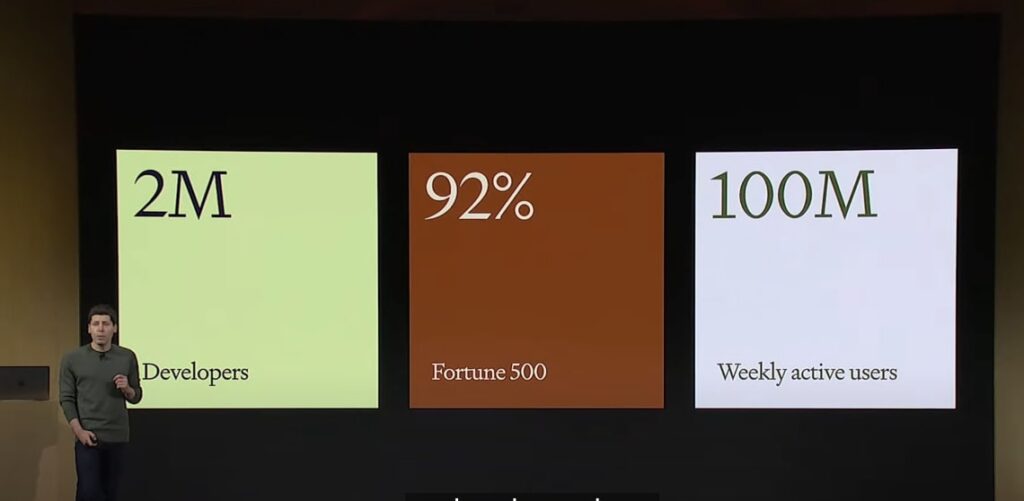

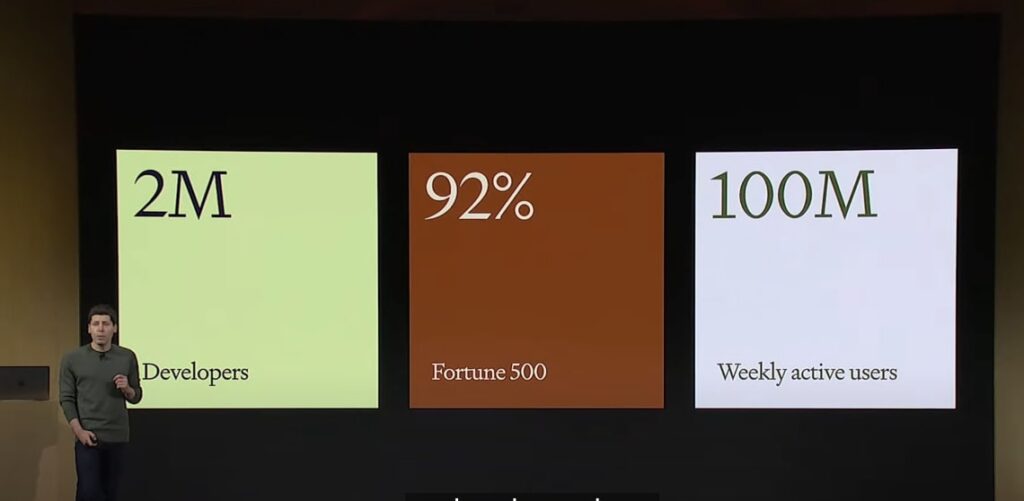

- 200万人もの開発者たちがGPTモデルのAPIを利用している

- フォーチュン500企業の内、92%の企業がGPTモデル利用している

- ウィークリーアクティブユーザー数が1億人

発表では、ChatGPTが人々の生活に使われているのか実際のユーザーの声がユーザーインタビュー動画として流されていました。

- より長いテキスト(最大128kトークン)おおよそ英文300ページ分の文字量と同等

- Jsonモードの追加

- ドキュメントやデータベースから知識を学習させる

- 大言語モデルのデータを今までの2021年9月から2023年4月までアップデート

- マルチモーダルAPI(複数のデータ種類)DALl-E3, GTP4V, TTS(text to speach)全てAPI可能

- Be My Eyes, WhisperV3について

- GPT-3.5ファインチューニング16kバージョンモデルへ

- GPT-4 ファインチューニング

- 企業向けカスタムモデル

- 1分ごとのトークン制限を2倍へ拡大

- API設定でトークンの制限レートをコントロール可能

OpenAIは、もし法的措置や著作権侵害などにより法的な請求が発生した場合は、ユーザーを守り、その発生した費用をOpenAIが支払うシステム。ChatGPTEnterpriseプランとAPIにおいて対象です。

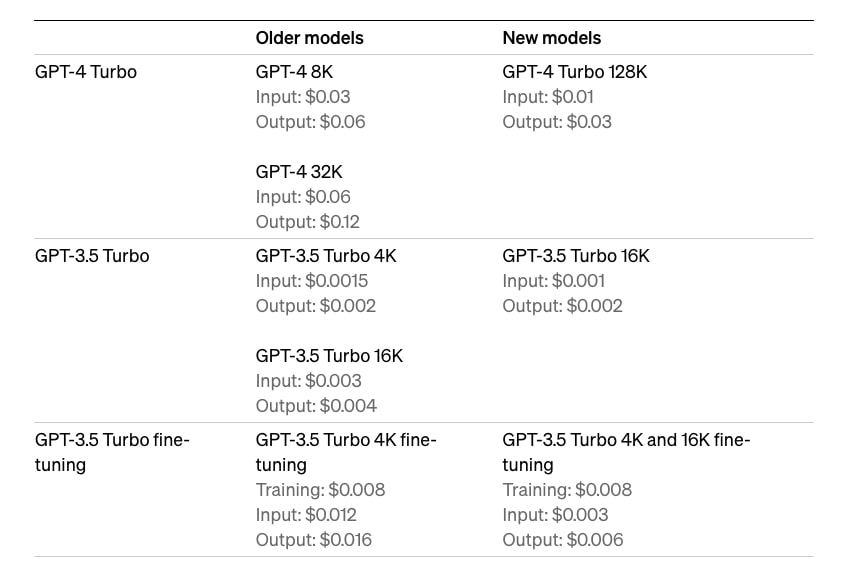

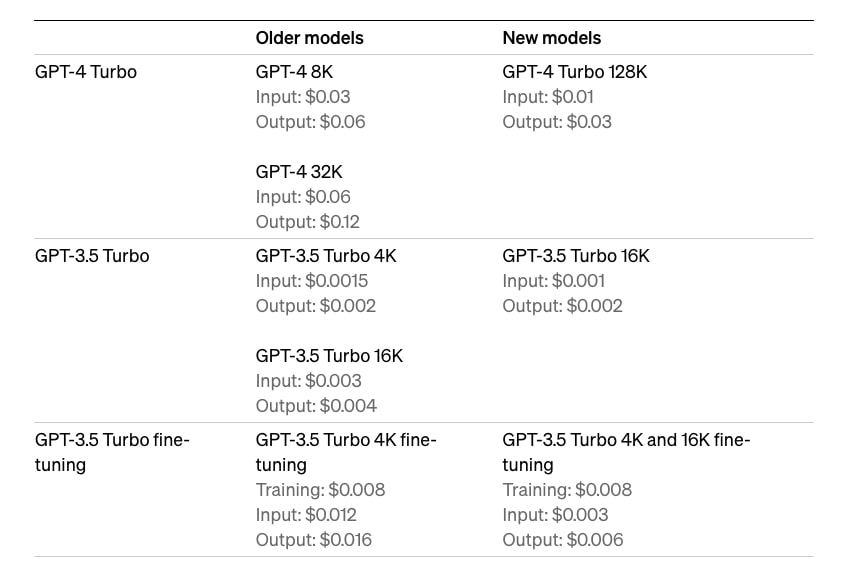

- インプットトークン:3分の1

- アウトプットトークン:2分の1

- 米ドル1セント/ 1,000インプットトークン

- 米ドル3セント/ 1,000アウトプットトークン

GTP-4Turboでは、多くのユーザーケースで、今までのGTP-4利用より2.75倍安くなる見込みです。

- $0.003 /1,000インプットトークン: 3分の1

- $0.004/ 1,000アウトプットトークン:2分の1

- ファインチューニング $0.003 /1,000インプットトークン: 4分の1

- ファインチューニング $0.006 /1,000インプットトークン: 8分の3(37.5%)

GPT3.5 Turbo 16kモデルは、以前のGPT3.5 4kモデルよりもかなり安くなっています。

GitHub CopilotやAzureを中心にOpenAIのGPTモデルのAPIサポートでベストなインフラを構築していくとのことです。

今後は、モードの切り替えなしに各機能が使えるようになります。

これによって、今までは、モードごとにチャットを新しくする必要がありましたが、

画像を読ませて画像を生成などが一つのチャットで可能になります。

ChatGPTを個々のニーズに合わせてカスタマイズできるようになります。

あなた自身の「AIエージェント」を作り、カスタマイズすることができることを意味します。

具体例として、教師の講義準備用にカスタマイズされた「Continue.org Lesson Planner」や

Canvasのクリエイティブ作成にカスタマイズされた「Canva GPT」、

タスクのオートメーションにカスタマイズされた「Zapier AI Actions」が紹介されました。

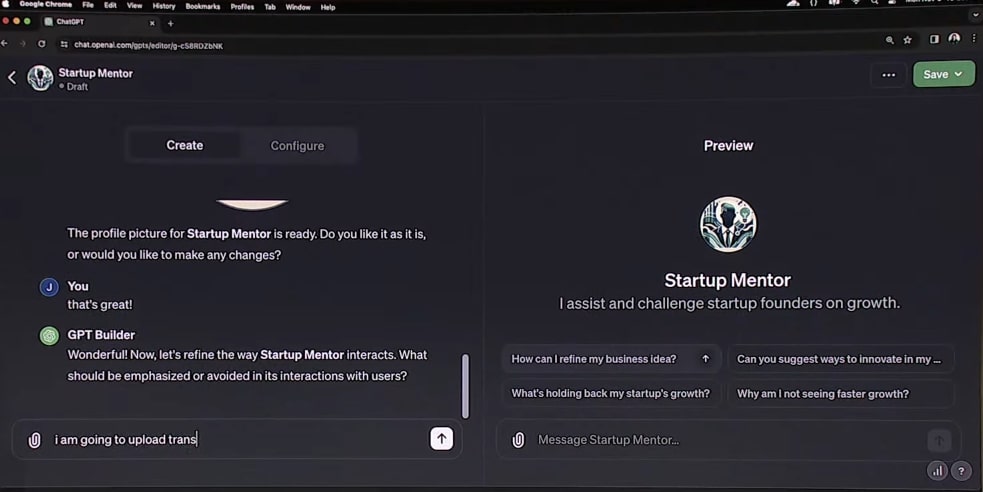

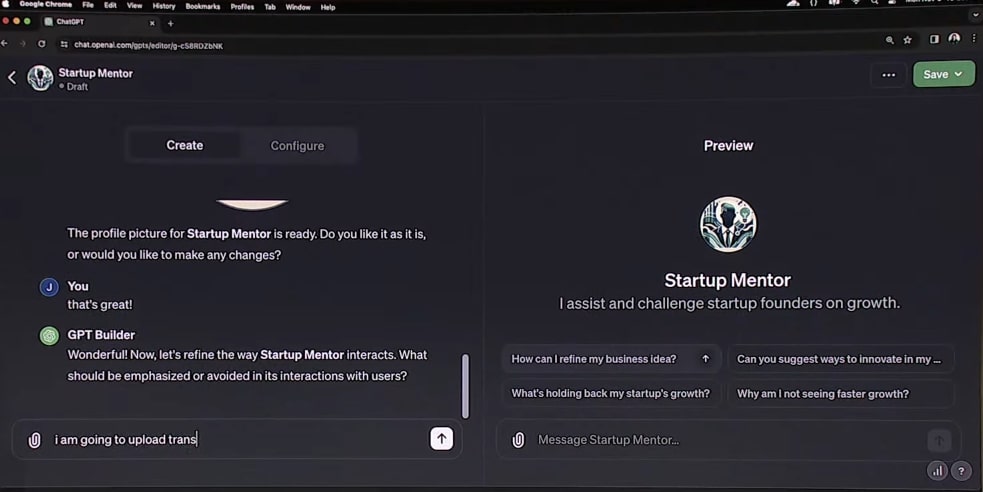

実際にどのようにカスタマイズモデルを構築できるかを紹介していました。

画面左側で、条件やその他の設定を行い、右側がモデルのプレビューとなっています。

モデルを作成したら、右上のSaveボタンで保存し、個人用に使用するか一般公開するかを選択できます。

「Code Interperter」、「外部データベース、ドキュメント等からのデータ取得」「より改善されたfunction calling」のような機能を持つAIアプリを簡単に作れるようになります。このAssistant APIにより複雑なコーディングから解放され、より複雑なタスクをより効率的に処理できるAIツールに一歩近づきました。

最後は、プレゼンのまとめ、OpenAIとして今後期待することや展望が話され、締めくくりとなりました。

GPT-4 Turbo:AIの新時代

GPT-4 Turboのリリースは、生成AI技術における新しいマイルストーンとなっています。

性能が格段に上がったのに対し、そのコストが驚異的に下がったことで、今後多くの企業や開発者によってAPIが利用され、新たなAIアプリが生まれてくるでしょう。

GPT-4 Turboの特徴と革新

GPT-4 Turboは、その先進的な特徴と革新により、生成AI分野における新たなスタンダードとなりました。

- 1プロンプトごとにより長いテキスト(最大128kトークン)おおよそ英文300ページ分の文字量と同等

- Jsonモードの追加

- ドキュメントやデータベースからデータを取得し、知識を学習させる

- 「Reproducible Output(再現可能な出力)」シード番号で一貫性を保った生成回答

- 大言語モデルのデータを今までの2021年9月から2023年4月までアップデート

- マルチモーダルAPI(複数のデータ種類)DALl-E3, GTP4V, TTS(text to speach)全てAPI可能

- Be My Eyes, WhisperV3によりアクセシビリティ向上

- GPT-3.5ファインチューニング16kバージョンモデルへ

- GPT-4 ファインチューニングの実験アクセス

- 企業向けカスタムモデル

- 1分ごとのトークン制限を2倍へ拡大

- API設定でトークンの制限レートをコントロール可能

こんなに進化の特徴があるなんて凄すぎる。。。

バージョンアップごとに拡張性が一気に広がるよね。

GPT-4 Turbo:AI技術の境界を破る

GPT-4 Turboは、生成AIの潜在能力を拡大し、新たな拡張性の可能性を切り開いています。

1つのプロンプトにおけるインプット、アウトプットのコンテキストが大幅に強化されており、

発表によれば、パフォーマンスも、GPT-4のそれを上回っているとのことです。

GPT-4 Turboは、生成AIの新たなスタンダードとなり、その応用範囲を広げることで、多くの業界に革新をもたらすでしょう。

GPT-4 Turboの力:強化されたコンテキストウィンドウとパフォーマンス

強化されたコンテキストの利点

GPT-4 Turboは、強化されたコンテキストと高速なパフォーマンスにより、ユーザー体験を大幅に向上させるでしょう。

GPT-4 Turboは、最大128kトークンで英文の文章でおおよそ300ページもの長文に対応します。

前モデルGPT-4では、一般向けChatGPT Plusプランは、インプットアウトプット合わせて最大8k、

企業向けEnterpriseプランでは、最大32kとなっていたので、ChatGPT Plusプランの約16 倍、

Enterpriseプランの4倍のトークンとなっています。

この進化により、大量のドキュメントを読み込ませて、要約したり、より長文のアウトプットを要求することが可能になり、

その結果、ChatGPTの応用できる範囲が拡大していくことが期待されます。

パフォーマンスの向上とユーザーエクスペリエンス

発表によれば、パフォーマンスがGPT-4よりも上がっているとのことで、よりスピーディな対話が可能になります。

GPT-4 Turboのパフォーマンスの向上は、ユーザーエクスペリエンスを根本から変える可能性を秘めています。

リアルタイムでのやり取りが高速化され、高速なデータ処理能力やそれに対してのフィードバックや解決策の提供がよりスムーズになるでしょう。

例を挙げると、カスタマーサポートにおけるチャットボットの応答がより精密、スピーディになったり、

教育アプリでのChatGPTによるリアルタイムの学習サポートなどがより高度なレベルになるでしょう。

GPT-4 Turboは、ユーザーがAIとのやり取りをより自然でスムーズに感じさせ、精度の高い回答を可能とし、新たなユースケースの開発につながると考えられます。

価格革命:開発者にGPT-4 Turboを手軽に

新しい価格体系により、GPT-4 Turboはより多くの開発者にとって手が届きやすいツールとなりました。

「APIの利用価格が、今よりもう25%ほど安くなったらいいのに」という多くのユーザーの声を拾って、

OpenAIは、この点に焦点をおいて、コストを下げられるよう開発を進めてきたそうです。

その結果、以下のよう価格設定を実現できたのとこです。

- $0.01 /1,000インプットトークン: 3分の1 (前モデルGPT-4 8k の価格と比べて)

- $0.03/ 1,000アウトプットトークン:2分の1 (前モデルGPT-4 8k の価格と比べて)

- ファインチューニング(GTP3.5 Turbo 4k/16k) $0.003 /1,000 インプットトークン: 4分の1

- ファインチューニング(GTP3.5 Turbo 4k/16k)$0.006 /1,000 アウトプットトークン: 8分の3(37.5%)

キーノートでは、今後GPT-4のファインチューニングの実験的アクセスを開始する予定と発表されました。

新しい価格体系とその意義

パフォーマンスが上がったのに対して、コストが下がったため、多くの開発者にとって手が届きやすいツールとなりました。

今後はGPT-4 Turboを利用する開発者が増えることでしょう。

この新価格設定により、OpenAIのAPIをベースとした様々なAIアプリが生まれてくることが予想されます。

その結果、さまざまなAIツールの使い分け、そして活用スキルが求められるステージになっていくでしょう。

開発者がAIを活用する際の障壁を減らして、技術革新への道のりの基盤がより固まってきたと言えます。

全体として2〜3倍安くなったなんて神だね!

GPTs:あらゆるニーズに合わせたカスタマイズChatGPTが作れる

ChatGPTのカスタマイズ性の向上により、ユーザーのニーズに合わせたChatGPTを作成することが可能となります。

カスタマイズ可能なChatGPTは、ユーザーが求める特定の機能や情報に合わせてAIを調整できるため、

よりパーソナライズされたサービスが提供可能になります。

AIのカスタマイズ:カスタマイズ可能なChatGPTモデル「GPTs」の登場

「GPTs」は、ChatGPTユーザーが、多様な目的に合わせてカスタムバージョンのGPTモデルを作成できる新機能です。

設定自体もコーディングが不要で、プロンプト同様に自然言語で簡単に設定が可能となります。

さらに外部からのデータ取得をして学習させたり、ウェブ検索、画像作成、データ分析機能の追加するかどうかの選択も可能です。

例えば、企業のユースケースでは、医療分野や金融分野など専門用語の多いに特化したChatGPTモデルや

教育分野では、特定の分野に特化した学習サポートChatGPTモデルなどが作成されることが期待されます。

カスタマイズモデルは、AIを個々のユーザーの具体的な要求に合わせて作成され、ピンポイントで効果を発揮するでしょう。

こちらのデモでは、子犬に関する知識に特化させた「Puppy Hotline」というカスタムGPTを実際に動かしている様子が映されています。そこでの会話は、以下のような会話になっています。

自分の子犬の写真を添付して、「カウボーイ(子犬の名前)に会って!」

カウボーイは、カワイイですね!あなたの子犬は、ダックスフンドであるように見えます。ダックスフンドは、知能が高くよくはしゃぐ性格で知られています。あなたの子犬のことで、何かお手伝いできることありませんか。

えーと、カウボーイは、シャンプーをするのが苦手みたいです。何かアドバイスありますか。(実際のシャンプーしている写真を添付)

カウボーイ!ドックフレンドリーで安全な犬用のシャンプー、温かいお水と褒め言葉や愛情を示してポジティブな経験をさせます。おやつなどもあげることで子犬がハッピーになり落ち着くでしょう。

私の娘が質問があります。

「なんでカウボーイは、こんなことをするの?」

(カウボーイが後ろ足を伸ばして伏せている写真を添付)

良い質問ですね!「Splooting(いぬが腹ばいで手足を伸ばしている状態)」によって、カウボーイは、涼んだり、足をストレッチしたり、リラックスしようとしています。

なるほど!今、私の子供たちが同じように「Splooting」しようとしています。でも、よくわかりました!

ChatGPT PlusプランとEnterpriseプランでは、このカスタムGPT機能によって作成された「Canva GPT」や「Zapier AI Actions」などが使用できるようになる予定です。

カスタマイズモデルの可能性

カスタマイズモデルは、AIの応用を無限に広げ、各ユーザーの独自のニーズに対応します。

特定のビジネスシチュエーションにカスタマイズされたChatGPTなど作成可能となります。

例えば、レストランを探すことに特化させたGPTモデルやカレンダースケジュール管理に特化させたGPTモデルなど、

ライフスタイルジャンルのカスタマイズモデルも作成されていくことでしょう。

ユーザー独自のChatGPTの作成

上記の他に、各ユーザーが自分のため、または友人やグループ内で使用する目的で、

特定の目的にカスタマイズさせることも考えられます。

例えば、スポーツや音楽など特定の個人の趣味や関心に合わせたChatGPTのカスタマイズや、

特定のイベント向けにカスタマイズさせたGPTモデルを作成できるでしょう。

また、ユーザー自身が一般向けや企業向けにサービス向上のための独自のGPTモデルを開発することもできます。

カスタマイズGPTについてのまとめ

- ChatGPTとの対話により、自分だけのGPTモデルを構築

- カスタマイズ項目には、モデル名称、説明文、カスタム指示、会話の起点、特定機能の選択、アクション、ファイルの追加、DALL-E3で作成したプロフィール写真があります。

- プログラミング知識不要。特定の目的や日常タスクのサポートなどに合わせたカスタマイズ

- 作成したカスタムGPTモデルを公開、非公開を選択可能

- PlusとEnterpriseプランユーザーは、今後数週間以内にhttp://chatgpt.com/createで自分のGPTを作成可能

- 今月末には、ユーザーが自作のGPTを登録・販売できるGPTストアの開設を予定しており、将来的にはさらに多くのユーザーにサービスを拡大する計画

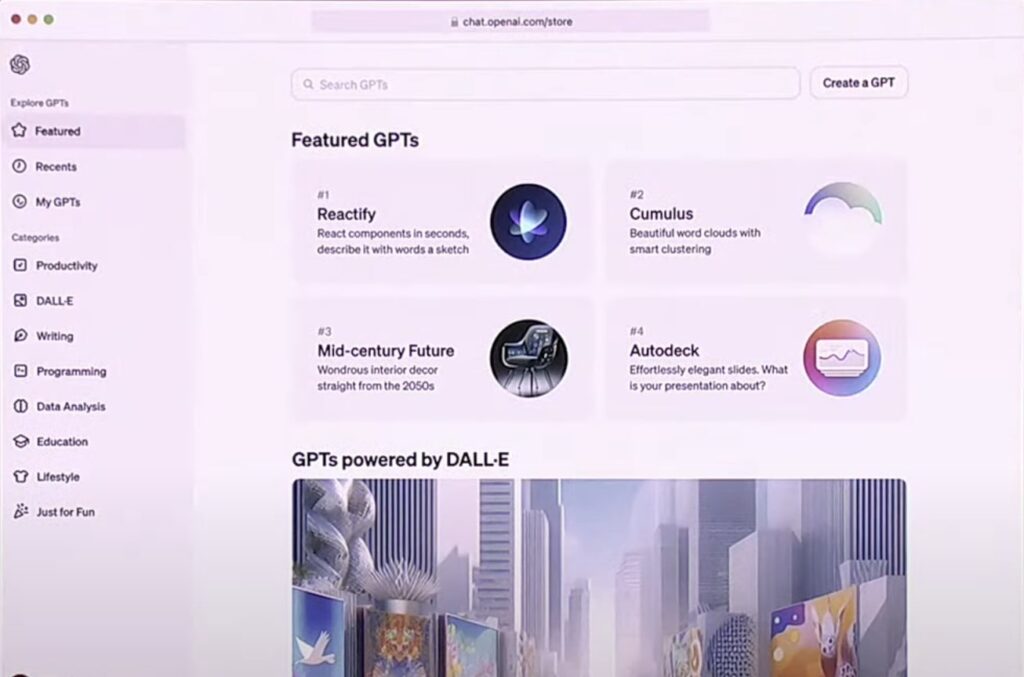

GPTストア:カスタマイズされたAIソリューションのマーケットプレイス

「GPTストア」は、ChatGPT版のAppストアのようなものです。

AppleのAppストアでは、年間8,000億ドルの売上があるのですが、このGPTストアは、年間売上何兆ドルを叩き出すゲームチェンジャーになる可能性を秘めているかも知れません。

GPTストアの意味するところ

ユーザー視点では、目的に合わせてストアにある多様なジャンルのカスタムGPTを利用することが可能となります。

それによって、AIのカスタマイズを簡素化し、ユーザーが必要とするソリューションを迅速に見つけることができます。

開発者視点では、コーディングの知識なしで、自然言語でカスタムGPTを作成でき、

自作のカスタムGPTをGPTストアに登録(審査を経て)し、多くの人に使われること収入を得ることができるようになるとのことです。

これが意味することは、インセンティブがあるので、多くの人や組織が良いオリジナルGPTを作ろうとします。

その結果、より多くの人や組織がAIを使うようになっていくでしょう。

GPTストアでのカスタムAIの役割

GPTストアで提供されていくカスタムGPTは、特定のニーズに合わせたソリューションを提供し、AIをより身近のものにすることでしょう。

今後AI利用がよりパーソナライズされていき、個々のユーザーに合わせ、「自立型AIエージェント」のような使い方が増えていくと思われます。

それが今までアップルストアのアプリをダウンロードして使う感覚で、今後多くの人、企業がChatGPTのGPTストアでカスタマイズされたGPTを利用していくことが期待されます。

GPTsは、発表を聞いただけで面白そう!

カスタマイズGPTを色々と早く試してみたい。

マルチモーダルAPIと新機能「Assistant API」

GPT-4が発表された2023年3月以降、

GPT-4には画像読み取り機能、ボイス機能、画像生成AIのDALL-E3など多くの機能が追加されてきました。

これによりChatGPTは、マルチモーダル化(複数の種類のデータに対応可能)したと言われておりましたが、

API利用では、まだこれらの機能が使えませんでした。

それが今回の発表で、API利用でもマルチモーダル化されることが発表されました。

それに加えて新しい機能として、「Assistant API(アシスタントAPI)」も合わせて紹介されました。

順に解説していきましょう。

マルチモーダルAPI:アシスタントAPI、GPT-4 with Vision、およびDALL·E 3 API

有料版のプランでは、ベータ版として以下のような新しい機能が使えるようになっていました。

- Webブラウジング機能(Browse with Bing)

- 高度なデータ分析機能(Advanced Data Analysis)

- プラグイン機能(Plugins)

- 画像アップロード(画像送信)機能

- ボイス機能

- DALL-E 3 (画像作成)

有料版の機能についてもっと知りたい方は、有料版の機能を含め無料版との違いを解説したこちらの記事もおすすめ。

しかし、これまでのAPI利用ではこれらの新しい機能は使えませんでしたが、今回の発表でマルチモーダルAPIの利用が可能になるとのことです。

これによって、開発者には新たな可能性をもたらします。

今後は、多くのアプリでこれらの機能が使えることになるでしょう。

例えば、DALL-E3の機能を使用したアートワークを生成が可能になったり、GPT-4 Visionの機能で画像を読み取りそのデータを分析するなどがアプリ上で可能になります。

開発者がAIを活用する多様な方法を生み出し、ユーザーは、これまでにない体験ができるようになるでしょう。

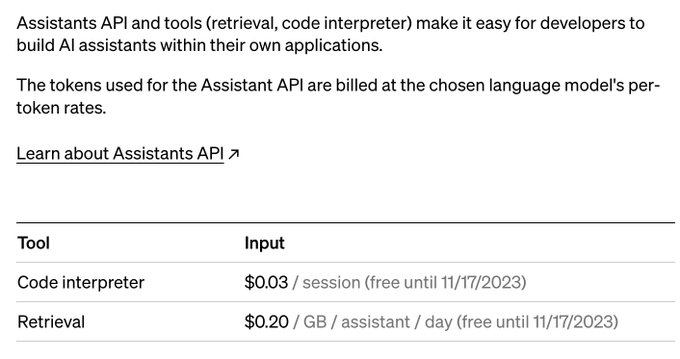

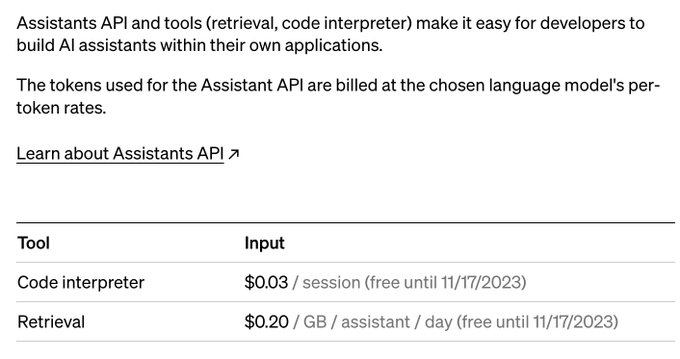

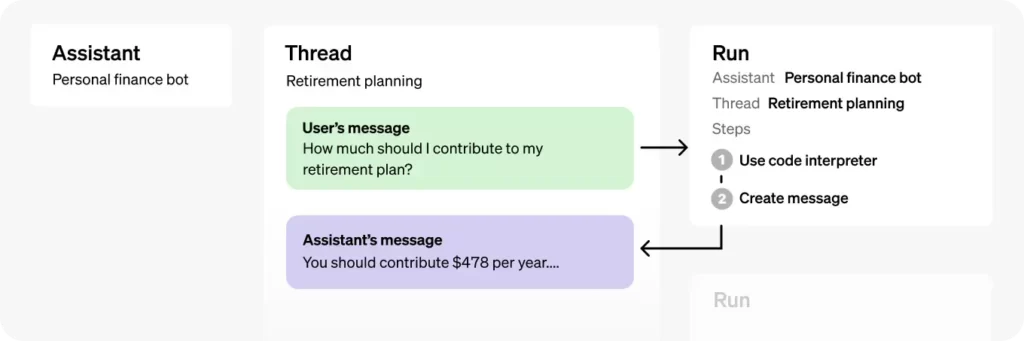

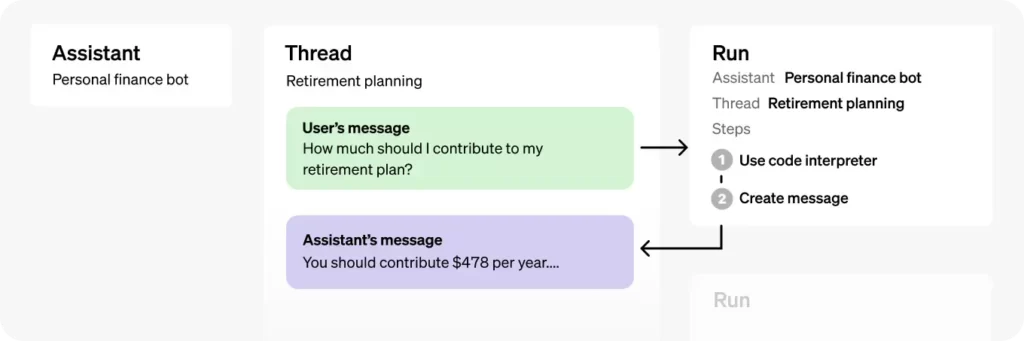

新機能: Assistant API(アシスタントAPI)

AIエージェントと呼ばれるような、オリジナルのAIアシスタントをアプリケーションに実装するための「Assistant API(アシスタントAPI)」が発表されました。

このAPIを利用することで、、ウェブ検索やコードインタープリター機能、ボイス機能などの機能を使って、AIエージェントのように複雑なタスクを実行できます。

Assistant Playgroundを使うことで、さらに簡単にカスタムGPTモデルを作成できるようになります。

上記は、アシスタントAPI機能の価格体系ですが、「Retrieval (データの取得)機能」については、コストが高めに感じます。

上部の図のフローは以下の通りとなります。

これにはOpenAIがホスティングするツール(コードインタープリタや外部データの取得など)と、自分で構築/ホスティングしたツール(関数呼び出しによる)の両方が含まれます。

スレッド(ユーザーとアシスタントとの会話セッションの事)はメッセージ履歴を保存し、会話がモデルのコンテキスト長を超えるほど長くなった場合に切り捨てることで、AIアプリ開発を簡略化します。

スレッドは一度作成し、ユーザーの返信に合わせてメッセージを追記するだけです。

これにはアシスタントの作成時や、アシスタントとユーザー間のスレッドの一部としてのアクセスが含まれます。

ツールを使用する場合、アシスタントはファイル(画像、スプレッドシートなど)を作成し、参照したファイルを作成したメッセージ中で引用することもできます。

上記の通り、特徴としてAPIが会話の内容を保持することで、持続的に無限に長い会話をすることが可能になります。

アシスタントAPIによりアクセスできる新しいツールは、以下の通りです。

- Code Interpreter(コードインタープレター)

-

サンドボックス環境でPythonコードを記述および実行し、グラフやチャートを生成したり、様々なデータやフォーマットのファイルを処理できます。これによりアシスタントはコードや数学の複雑な問題を反復的に解決するためにコードを実行できるようになります。

- 外部データ取得(知識の検索)

-

ドメイン固有のデータや製品情報、ユーザーが提供するドキュメントなど、モデルの外部の知識でアシスタントを拡張します。これによりドキュメントの埋め込み表現を計算・保存したり、検索アルゴリズムを実装する必要がなくなります。APIはChatGPTでの知識検索の経験に基づき、状況に応じて最適な検索技術を選択します。

- Function Calling (関数の呼び出し)

-

シスタントが定義した関数を呼び出し、そのレスポンスをメッセージに含めることができます。

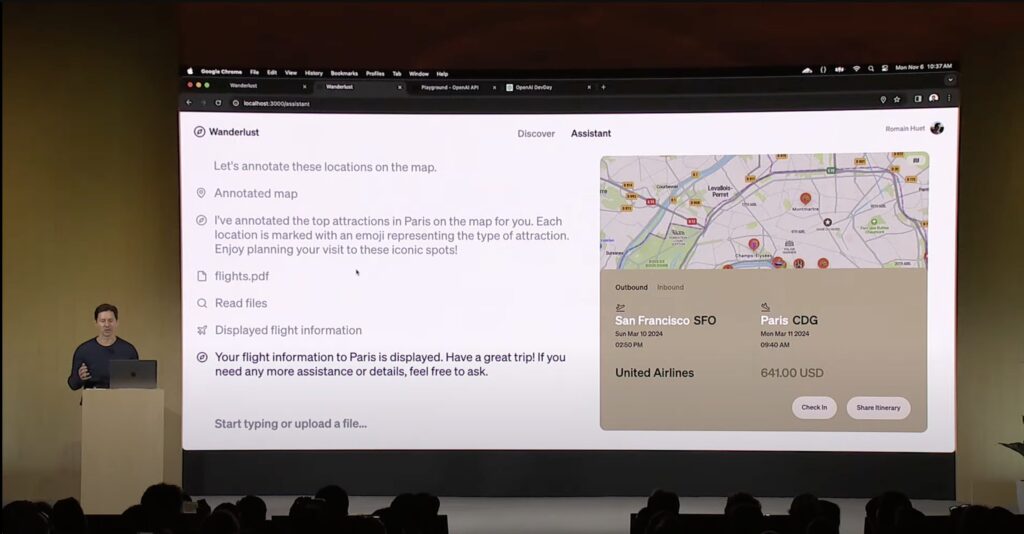

今回の「DevDay」のキーノートでは、行き先を入力したり、フライトチケットや宿泊先予約資料をアップロードすることで、旅行計画を作成し、場所の紹介についてもマップで同時にピンされて表示される旅行アプリが紹介されていました。

Assistant APIを利用することで、簡単にアプリ内でAIエージェントのような体験ができる。そしてこの設定がGUIで簡単に設定できるなんて。これは、今後いろんなアプリで導入されていきそう。。。

GPT-3.5 Turbo 改善バージョン

コストパフォーマンス型の選択肢がある点、多様なニーズに合わせている点が伺えます。

今回改善されたバージョンのGPT-3.5 Turboが合わせて発表されました。

GPT-3.5 Turboの改善点とGPT-3.5 Turbo 16kのコスト削減

- JSONモードや並行Function Calling機能の追加によりJSON, XML, YAML生成のようなタスクにおいて38%の改善が実現

- GPT-Turbo 16Kでコスト削減を実現

- 16Kでのコストは、インプットで3分の1, アウトプットで2分の1に

- ファインチューニングでのコストは、インプットで4分の1,アウトプットで8分の3(37.5%)

効率性とコスト削減のバランス

GPT-4 TurboのAPIを用いて、ハイエンドなAIサービスを創出できる一方で、GTP-3.5 TurboのAPIを利用することで、

コストを意識しながらも高品質なAIサービスを求める開発者にとっては有効的な選択肢が残されています。

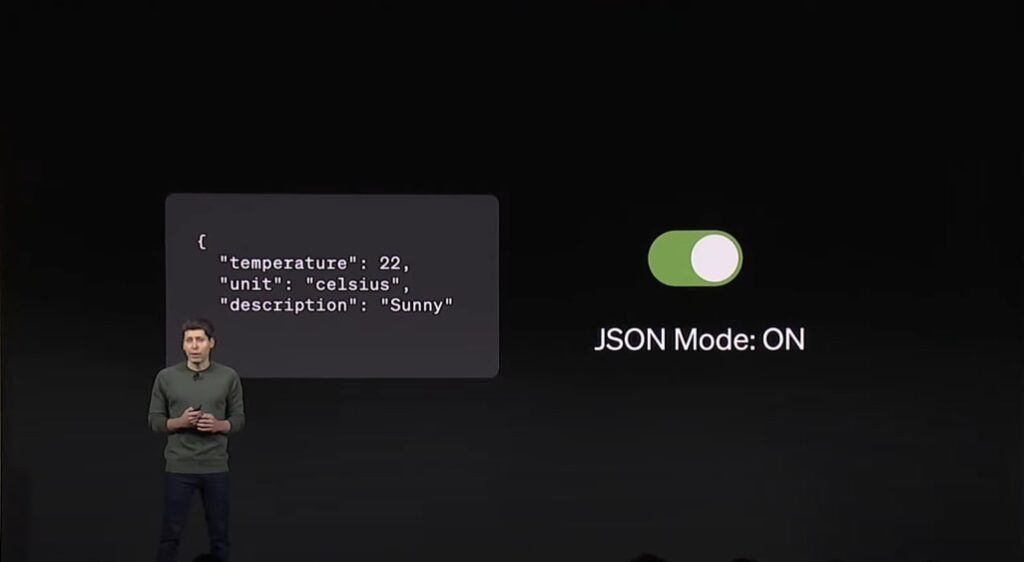

新機能 JSONモードについて

今まで生成されたアウトプットには、正しいJSONにパースしない出力がありました。

このエラーに対応する形で作られた機能が、「JSONモード」です。

この機能をオンにすることで、正しいJSONのパース可能な文字列のみを生成するように制約されます。

APIで設定する際、モデルのパフォーマンスを向上させるには、gpt-4-1106-preview または gpt-3.5-turbo-1106 を呼び出す際に、response_format を { type: "json_object" } に設定することでJSONモードを有効にできます。(OpenAI Documentation JSON mode 参照)

シード値の指定

画像生成でお馴染みとなっていますシード値が、ChatGPTで使えるようになります。

ChatGPTは、通常毎回異なる出力をします。

これシード値という数値が出力ごとに振られているので、この値を次のプロンプトで指定してあげることで、

この指定したプロンプトに対して一貫性のある出力が可能となります。

画像生成で例を挙げると、一つ前のプロンプトで出力された画像について、修正を指定したい場合、

シード値を指定することで、この画像の修正をすることができます。

シード値をしないで、追加のプロンプトをすると、一つ目のプロンプトとは異なる画像が出力されます。

このようにプロンプトの出力をシード値で指定することで、プロンプトごと違う出力がされるのではなく、

一貫性を保った出力が可能とります。

Function Calling(関数呼び出し)のアップデート

今回のアップデートで、「精度が向上し、1メッセージで複数の機能を呼び出せるようになりました」。

こちらの内容を解説する前に、まずはFunction Calling(関数呼び出し)について、簡単に説明します。

この機能は、コンテキストを理解して関数を実行する機能です。

例えば「リビングの電気をつけて」と言えば、「リビングの電気をつけるプログラミングを実行」するイメージです。

これまでこのような機能はあったのですが、「居間の電気をつけて」など「リビングの電気をつけて」と同じ意味であるのに、表現の方法や言い方などが人それぞれ異なるため、すべてのパターンをプログラムに組み込む必要があり、大変な作業でした。

そこでこの「Function Calling(関数呼び出し)」を使うと、とても簡単になります。

これをAI技術が発達したことで、どんな文章で表現されていても、

「リビングの電気をつけてほしい」というユーザーの意図をAIが読み取ることができれば、AIがリビングの電気をつけるプログラムを実行してくれるようになりました。

そこで、この関数呼び出し機能が今回アップデートされたとのことです。

- 1メッセージで複数の機能を呼び出すことが可能に

- 精度の向上

例えば、これまで「リビングの電気をつけて、明るさを50%の明るさにして」みたいな内容は、別々に入力する必要がありました。

「リビングの電気をつけて」、「明るさを50%の明るさにして」と別々に入力する必要があったのが、

今回のアップデートで、「リビングの電気をつけて、明るさを50%の明るさにして」のように複数のアクションが、1つのメッセージで実行可能になりました。

TTS(Text To Speach)APIのリリース

こちらは、テキストの読み上げができる機能です。

現在のところ英語のみ対応していますが、今後多言語での対応可能になっていくことが予想されます。

画像認識機能や、音声認識機能と組み合わせることで、音声でのより高度な会話が可能になります。

これはAIのアクセシビリティを向上させることにもつながります。

ChatGPT All Toolsで全ての機能が1つのチャットで使用可能に

全ての機能が統括され、1つのチャットですべての機能が使えるようになると発表されました。

この中でも特にDALL·E 3とGPT-4 Turbo with Visionは、生成AIの応用できる範囲を飛躍的に向上させます。

image to image生成と画像とテキストの統合

今まで「image to image」、つまり画像を読み込ませてそれに基づいて画像を生成するということは難しい状況でした。

それは、Dall-E3の機能をオンにしたチャットでは、画像読み込みが機能が使えないからです。

画像読み込み機能は、機能選択で「Default( デフォルト)」を選択したチャット内のみとなっています。

こちらの記事では、疑似的に「image to image」を実現する裏ワザを紹介しているので、ぜひそちらも読んでみてください。

この画像読み込み機能とDALL-E生成機能が1つのチャットで可能になると、

画像を読み込ませて、それをベースに画像生成することが可能になります。

ただし、これは上記の記事でも説明の通りですが、著作権に触れる場合があるので十分に気をつけてください。

そのほかの、画像とテキストを両方をプロンプトに含めることで、情報の理解を深めて、AIの能力を最大限に活用できるようになります。

今まで機能切り替えのたびに新しいチャットを開く必要があったのが、面倒だったんだよね。同じチャットで出来たらもっといいのにと思ってたところで、このアップデートは、素晴らしい!

アクセシビリティの向上:Be My EyesとWhisper V3

Be My Eyes:AIで隔たりを埋める

視覚障害や低視力の人々が、目の前にある商品について調べたいなどの日常のタスクで、6つのプリセットボイスを選べる新しいスピーチモデルによって非常に自然な音声会話をAPIで可能にします。

つまり、カメラで商品の画像を撮影し、アップロードして画像を認識させ、音声で質問し、その回答を音声で再生ということが可能になります。

Whisper V3:多言語パフォーマンスとカスタマイズ

Whisperは、2022年9月にOpenAIが発表した汎用的な音声認識モデルです。

様々な音声データの大規模なデータセットで学習されているため、多言語音声認識、音声翻訳、言語識別など、複数のタスクをこなすことができるマルチタスクモデルです。

インターネット上から収集された合計68万時間におよぶ音声データでトレーニングされており、認識した音声をもとに文字起こしをすることができます。

多言語モデルになっており、日本語にも対応しています。

そのWhisper モデルの最新版である「Whisper V3(Whisper large-v3)」が紹介されました。

Whisper V3:前バージョンとの違いと特徴

「Whisper V3(Whisper large-v3)」は、OpenAIに開発された音声認識モデルの新しいバージョンです。

- インプットのメル周波数ビンが以前の80から128へ

- 広東語の新しい言語トークンの追加

- 弱くラベル付けされた100万時間のオーディオとlarge-V2バージョンを利用し収集した400万時間の擬似ラベル付きオーディオで学習トレーニング済

- 多様な言語に対して改善された性能を示しており、、特にCommon Voice 15とFleursにおいて、60%以下のエラーレートを達成した言語では、large-v2に比べて10%から20%のエラー削減を示している

この情報から、V3バージョンでは、より高精度で音声からの文字起こしが可能になると言えるでしょう。

ビジネス向けカスタムGPT-4 Turboモデル

OpenAIによる企業向けカスタムモデルプログラム

カスタムモデルプログラムの概要

OpenAIは、各企業独自のニーズに合わせてモデルをカスタムするサービスを提供します。

つまり、カスタムモデルプログラムは、企業が特定のビジネス課題に対応するためのAIモデルを開発できるよう支援します。

それは、学習トレーニングプロセスの各ステップを修正したり、ビジネスドメインに合わせて追加的な

特定の事前トレーニング(プリトレーニング)や事後トレーニング(ポストトレーニング)を行います。

多くの企業と一度にこのプログラムを進めることは難しいので、

まずは1度OpenAIに直接相談することで、このプログラムに参加できるようです。

価格については公表されていませんが、キーノートでOpenAI CEOのサム氏は、

「安くはありませんが、GPTを可能な限り現在可能なレベルで最大限活用したいとお考えであれば、我々に連絡ください」と発言していました。

カスタムモデルプログラムは、企業がAIの力を最大限に活用し、ビジネスの特定のニーズに対応するため道を開いていくことが期待されます。

競争力の優位性を構築:特定のドメイン向けのカスタムモデル

ビジネス向けカスタムGPT-4 Turboモデルは、企業の特定のニーズに合わせたAIソリューションを提供し、競争力を高めます。

ドメイン特化モデルの開発

この企業向け、特定のドメインに特化したカスタムモデルを開発することによって、業界特有のニーズに合わせたAIソリューションを提供し、ビジネスの効率と精度を高めます。

ドメイン特化モデルは、業界固有の複雑な問題に対するカスタマイズされた解決策を提供し、ビジネスの成長を加速するでしょう。

ビジネスニーズへのカスタマイズ

ビジネスニーズへのカスタマイズは、企業が市場での競争力を維持し、顧客満足度を高めるために不可欠です。

「カスタムAIソリューションの採用による顧客満足度の向上」など挙げられます。

例えば、Amazonや楽天ショッピングなどでも良くみられるカスタマイズされたリコメンデーションシステム(あなたへのおすすめ)を使用しているEコマースプラットフォームなどです。

カスタマイズされたAIソリューションは、企業が顧客の期待を超えるサービスを提供し、持続可能なビジネス成長を実現するための鍵となるでしょう。

OpenAIが補償:「Copyright Shield( 著作権保護シールド)」

すでに発表があったGoogleやMirosoftと同様に、もし法的措置や著作権侵害などにより法的な請求が発生した場合は、ユーザーを守り、その発生した費用をOpenAIが支払うシステム。ChatGPTEnterpriseプランとAPIにおいて対象です。

企業や開発者が利用するケースにおいて懸念されるポイントをひとつずつ消去していこうとしている姿勢が見えるよね。

より安全性を確保し、高速で無制限にGPT最新バージョンを使えるEnterpriseプランとこの著作権保護シールドの組み合わせで、今以上に企業で導入されるケースが増えていきそう。ただし、いくらシールドがあるからといっても、大切なのは著作権侵害をしないように予防することだから、企業で導入する際には、しっかりとした従業員育成オンボーディングが必要となるよね。

Microsoftとのパートナーシップ

MicrosoftとOpenAI:共にAIの未来を築く

MicrosoftとOpenAIのパートナーシップは、AI分野における革新的な進歩を促進し、業界をリードする共同開発を実現しています。

今回のイベントには、Microsoftのサティア・ナデラCEOが登壇し、今後もパートナーシップが強化されていく方針が明らかになりました。

Microsoftとのパートナーシップの強化

今回発表されたGTP-4 Turboモデルは、世界トップレベルの大規模言語モデルであり、Microsoftは、OpenAIのGPTモデルのAPIサポートでベストなインフラを構築していくとのことです。

共同開発の未来像

GitHub Copilotでは、OpenAIのGPTモデルをベースとして、コメントやコードから次に書くべきコードを予測して提案します。

また、Microsoftが提供するクラウドコンピューティングサービスである「Azure」では、OpenAIとMicrosoftのパートナーシップにより、Azure上でOpenAIのAIモデルを利用することが可能になっています。

Azure AIは、機械学習、コグニティブサービス、ボットサービスなど、多岐にわたるAI機能を提供しています。

これにより、開発者は自分のアプリケーションに簡単にAI機能を組み込むことができます。

OpenAIとMirosoftとのパートナーシップは、AI技術の民主化を目指しており、開発者が容易にアクセスできる形で最先端のAI技術を提供することを目的としています。

今後一般ユーザーをはじめ、企業や開発者はより強力で拡張性があるAIソリューションを利用できるようになっていくことが期待されます。

まとめ:新発表のハイライトと今後予想される将来の展望

OpenAI DevDay新発表のハイライト

OpenAI Dev Day キーノート 新発表内容まとめ

- GPT-4 Turbo

- 128Kトークン 英文の文章約300p相当

- 大言語モデルのデータを今までの2021年9月から2023年4月までアップデート

- パフォーマンス向上したのに対し、APIコスト大幅に値下げ

- JSONモード

- シード値パラメーターの導入

- Fucntio Calling機能(関数呼び出し機能)アップデート

- TTS(Text To Speach)APIのリリース

- ChatGPT All Toolsで全ての機能が1つのチャットで使用可能に

- Be My Eyes, Whisper V3により、アクセシビリティ大幅向上、ChatGPT の「見る」「聞く」「話す」機能

- 今後GPT-4のファインチューニングの実験的アクセスを開始

- 独自カスタム機能

- API利用でのレート制限引き上げ

- より高い制限レート(1分あたりのトークン制限レートを2倍へ拡張)

- GPTs: ノーコードで作成可能なカスタマイズGPT

- 特定の目的や日常タスクのサポートなどに合わせたカスタマイズ

- 作成したカスタムGPTモデルを公開、非公開を選択可能

- GPTストア

- ApplenoのAppストアみたいなもの

- ユーザーが自作のGPTを登録・販売できる

- マルチモーダルAPI(複数のデータ種類)DALl-E3, GTP4V, TTS(text to speach)全てAPI可能

- 新機能 開発者向けAssistant API(アシスタントAPI)

- APIが会話の内容を保持することで、持続的に無限に長い会話をすることが可能

- Code Interpreter、Retrieval(外部データの取得)、Function calling(関数)の呼び出し

- ChatGPT-3.5 Turboの改善バージョン

- JSONモードや並行function calling機能の追加によりJSON, XML, YAML生成のようなタスクにおいて38%の改善が実現

- GPT-Turbo 16kでコスト大幅削減を実現

- 企業向け個別カスタマイズモデル

- 企業が特定のビジネス課題に対応するためのAIモデルを開発できるよう支援

- Copyright Shield( 著作権保護シールド)

- もし法的措置や著作権侵害などにより法的な請求が発生した場合は、ユーザーを守り、その発生した費用をOpenAIが支払うシステム

- Microsoftとのパートナーシップ強化

- Github Copilot

- Azure

今回の初めて開発者向けに開催されたカンファレンスで発表された内容は、非常にボリュームがあり、今後の拡張性に対する期待に胸が躍る内容でした。

この先、多様なカスタムGPTが生まれて、多くの人々や企業にAIが浸透していくイメージが湧いて、

まるでアップルのスティーブ・ジョブズによる初代iPhoneのプレゼンを見ているようなデジャブ感がありました。

この発表から予想される将来の展望

- マルチモーダルAPIが利用されたAIアプリの台頭

- 既存のAIアプリの機能改善

- AIアプリの収益化が実現していき、より多くのAIアプリが生まれる

- AIがパーソナライズされるステージへ

- ビジネス著書などの販売にカスタムGPTを別途販売して、学習専用ボットを作成を促す。

- 画像読み取り&生成( image to image)のアプリ

今回の発表で、いろんな可能性が見えて今後が楽しみすぎてしょうがないわ。

最後に

今後、GPT-4 TurboやカスタムGPTなどが解禁され次第、実際に検証していきたいと思います。

後日またその記事を公開していきます。

上記の将来展望から言えることは、個人レベル企業レベルで今後AI技術が浸透していくでしょう。

各自が、各社がそれぞれパーソナライズされたAIを活用していく時代が来ています。

そこで、重要なのは基本的なAIについて、そしてそれぞれのAIツールについて、正しい知識や使い方を学び、実際に手を動かして使ってみることで、Aiを活用できるスキルを身につけることができます。

AIに淘汰されるのではなく、Aiを使いこなせるようになっていきましょう。

当ブログでは、初心者からでもAIを学べるようAIについての知識の集約、解説、ChatGPTのおすすめスキルなどを発信して行きます。

よかったら、是非、ブックマーク&フォローしてください。