最近、生成AIの進化が目覚ましく、Open AIがプロンプトから動画を生成できる AI「 SORA」を発表してから動画生成についても注目されるようになりました。

そこで動画生成として注目をされるようになったのが、「Runway」という動画生成AIで、その最新版であるRunway Gen-3 Alpha が2024年7月1日にリリースされました。

動画を生成できるこのAIツールは、クリエイティブ業界だけでなく、マーケティングやコンテンツ制作の分野でも大きな話題となっています。

この記事では、この最先端の動画生成AI「Runway Gen-3 Alpha」の魅力を徹底解説し、その使い方やおすすめのプロンプトを詳しく紹介します。

Runway Gen-3 Alpha Turboは、プロンプトからの動画生成だけでなく画像から、プロフェッショナルレベルの動画を驚くほど簡単に作成できることで話題です。

その高速な処理能力と直感的なユーザーインターフェースにより、AI初心者から経験豊富なクリエイターまで、誰でも手軽に高品質な動画を制作できます。

さらに、このツールは最新のアルゴリズムを採用しており、よりリアルで鮮明な映像を生成することが可能です。

この記事を読むことで、Runway Gen-3 Alpha Turboを使ってどのように画像やプロンプトから魅力的な動画を作成できるのか、その秘訣を学ぶことができます。

これから紹介する使い方やプロンプトの例は、あなたの制作活動を一段と高めるための貴重なヒントとなるでしょう。動画生成AIに興味がある方、または最新のクリエイティブツールを探している方にとって必見の内容です。

- 生成AIで動画を作れることに興味がある方

- 画像から動画を作成してみたい方

- AI動画生成を活用してみたい方

レイ

レイ動画生成AIと言えば、やはりOPEN AIが2024年上半期中に発表した「SORA」の衝撃が大きかったよね!プロンプトから動画が生成されてしまうなんて驚きでしかないよな。そんな中いち早く動画生成AIとしてのポジションを確立してきたのが、このRunway!今回バージョンアップされてどんなことができるのか気になるね。その実力を見てみよう!

Runway Gen-3 Alpha の基本機能とAI動画生成の概要

Runwayは、Runway AI, INC.(RunwayまたはRunwayMLとしても知られる)によって開発された動画生成AIモデルです。

この会社は、チリ人のクリストバル・バレンスエラ、アレハンドロ・マタマラ、ギリシャ人のアナスタシス・ゲルマニディスがニューヨーク大学ティッシュ・スクール・オブ・アーツのITPで出会ったことをきっかけに、2018年に設立されました。同年に200万ドルを調達し、マルチメディアアプリケーション内で機械学習モデルを大規模に展開するプラットフォームを構築しました。

2020年12月にはシリーズAラウンドで850万ドル、2021年12月にはシリーズBラウンドで3500万ドルを調達しました。2022年8月には、ルートヴィヒ・マクシミリアン大学ミュンヘンのCompVisグループと共同で、改善されたLatent Diffusionモデルをリリースしました。

2022年12月にはシリーズCラウンドで5000万ドル、2023年6月にはシリーズCの拡張ラウンドで1億4100万ドルを調達し、これによりGoogle、Nvidia、Salesforceなどから評価額15億ドルを受けました。この資金は、映画やビデオ制作で使用されるマルチモーダルAIモデルの構築に充てられます。

2023年2月には、初の商業用動画生成モデル「Gen-1」と「Gen-2」を公開し、ウェブインターフェースを通じて利用可能にしました。そして2023年6月には、TIME誌により世界で最も影響力のある100社の一つに選ばれました。

そこで2024年は、7月1日に新バージョン「Gen-3 Alpha」がリリースされ、その1ヶ月半後の8月15日には、マイナーバージョンアップした「Gen-3 Alpha Turbo」がリリースされ話題になっています。

Wikipedia記事より引用

Wikipedia:Runway AI, Inc.

Runway Gen-3 Alpha とは?

Gen-3 Alphaは、Runwayの動画生成AIモデルの最新バージョンであり、Gen-1およびGen-2に続くものです。

忠実性、一貫性においてGen2より大きな改善がされました。

Runway Gen-3 Alpha Turboの前にその前提となるGen-3 Alphaについて説明します。

主な特徴は、以下の通りです。

- 高度な動画生成

-

テキストプロンプトや画像から高精度で一貫性があり、動きに富んだ動画を生成することができます。特に、幅広いアクション、ジェスチャー、感情を表現する人間キャラクターの生成に優れており、動画による新しい形のストーリーテリングの可能性を引き出します。

- マルチモーダルトレーニング

-

このモデルは、大規模なマルチモーダル学習のために構築された新しいインフラストラクチャ上でトレーニングされており、動画と画像のトレーニングを組み合わせています。これにより、Runwayのエコシステム内のさまざまなツール(テキストから動画、画像から動画、テキストから画像)を強化します。

- 細かな時間制御

-

Gen-3 Alphaは、非常に詳細で時間的に密度の高いキャプションでトレーニングされており、想像力豊かなトランジションやシーン内の要素の正確なキーフレーム設定を可能にしています。

- フォトリアル(写実性の高い)人間キャラクター

-

Gen-3 Alphaは、幅広いアクション、ジェスチャー、感情を持つ表現力豊かな人間キャラクターの生成に優れており、新しい物語の可能性を引き出します。

- アーティストによるアーティストのために

-

Gen-3 Alphaのトレーニングは、研究科学者、エンジニア、アーティストからなる学際的なチームの協力によって行われました。このモデルは、幅広いスタイルや映画用語を解釈できるように設計されています。

このモデルは、映画制作、広告、メディア制作、教育、ゲーム、そして仮想現実開発など、さまざまな業界に対応するように設計されています。Runwayは、特定の芸術的および物語的要件に応じたカスタムバージョンのGen-3を作成するために、主要なエンターテインメントおよびメディア組織とも協力しています。

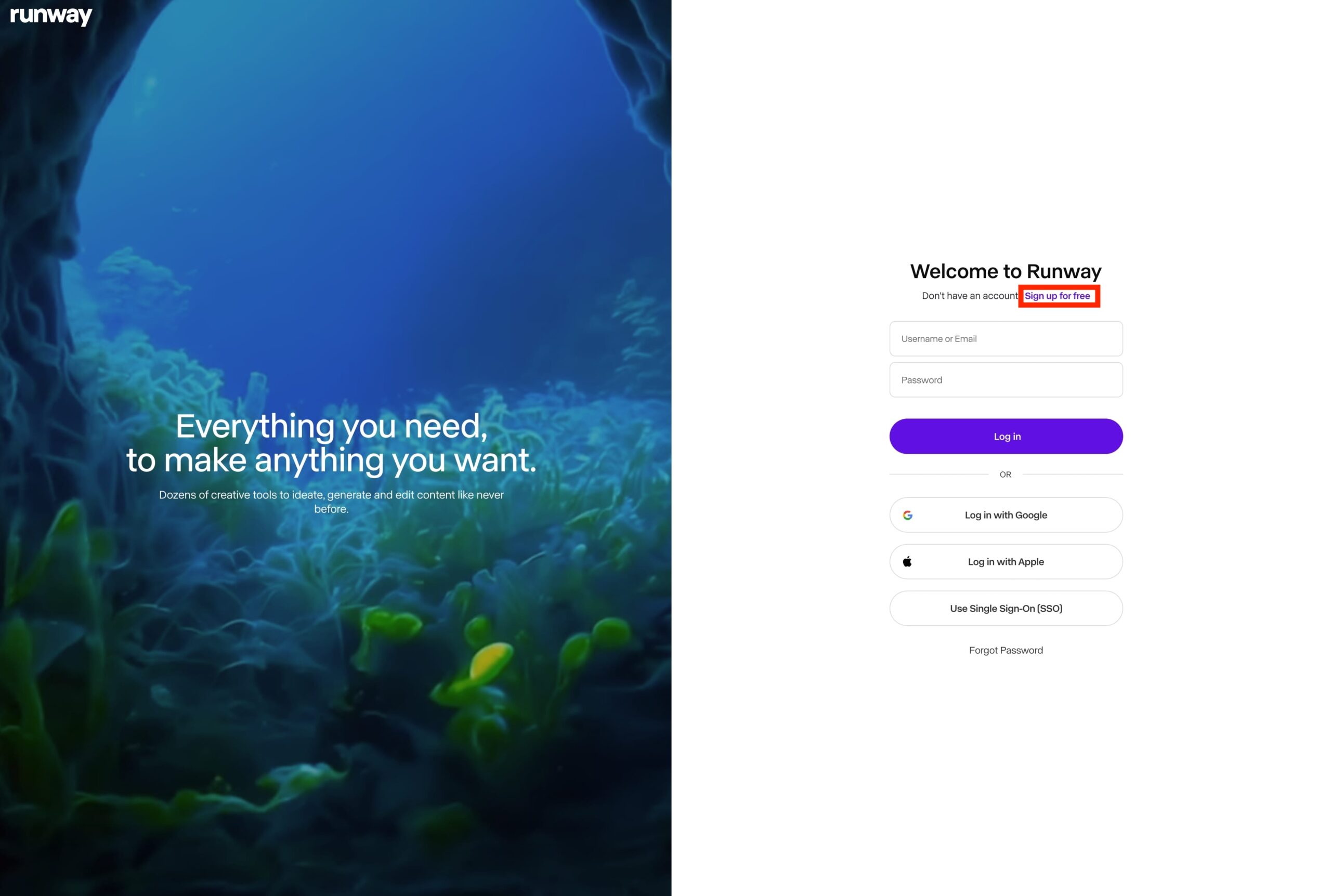

Runway 公式ホームページ内gen-3 alpha 紹介ページ

引用元:Introducing Gen-3 Alpha: New Frontier for Video Generation

Runway Gen-3 Alphaは、AIを活用した動画生成における大きな飛躍を示しており、クリエイターや業界に対して、これまでにない品質とコントロールを持つ新しいストーリーテリングやビジュアルコンテンツ制作のツールとなるでしょう。

Gen-3 AlphaはGen-2と何が違うの?

| 特徴 | Runway Gen-3 Alpha | Runway Gen-2 |

|---|---|---|

| 画質 | より高品質で写実的 | Gen-3よりも低品質 |

| 一貫性 | フレーム間の一貫性が向上 | 一貫性にやや欠ける |

| モーション | より自然で滑らかな動き | 動きがぎこちない場合あり |

| 生成時間 | 10秒の動画を生成可能 | 4-5秒の動画生成が限度 |

| 入力オプション | テキスト、画像、既存動画から生成可能 | テキストと画像のみ |

| 時間的制御 | より精密な時間的制御が可能 | 時間的制御は限定的 |

| 人物表現 | 表情豊かで多様な動作が可能 | 人物表現に制限あり |

| トレーニング | マルチモーダルな大規模インフラで訓練 | Gen-3ほど高度なインフラではない |

Gen-3 Alphaは全体的に大幅な改善が見られ、より高品質で柔軟性の高い動画生成が可能になっています。

特に人物表現や時間的制御、そして画像から動画と入力オプションが増えて大きく進化しました。

Runway Gen-3 Alpha Turboとは?

2024年7月1日リリースされたばかりのGen-3 Alphaですが、8月15日により速度の速さとコスト重視をしたバージョンであるGen-3 Alpha Turboがリリースされました。

- 動画の生成速度がGen-3 Alphaの7倍

- 生成コスト半分

速度の向上により、ほぼリアルタイムでの動画制作が可能となり、AI動画生成におけるタイムラグの問題を解決しています。

コストに関しては、生成される動画の1秒あたり5クレジットを使用し、これはGen-3 Alphaの10クレジットと比較して半分のコストになっています。

- ダイナミックな動きのある動画を生成するのが得意

- 複雑な動きをする動画が得意

- Gen-3 Alpha Turboに比べて、よりクリエイティブな動画を生成しやすい

- 生成速度がAlpha Turboに比べて遅い分、コストが高いのがデメリット

- 動きの少ない安定した動画を生成するのが得意

- Gen-3 Alphaに比べて元の画像に忠実な動画を生成する

- 生成速度が7倍の速さなので非常に生成速度が速く、コストが低い

最新バージョンのGen Alpha Turboは、無料版でも使える(無料クレジット分のみ)ので是非試してみてください。

Gen-3 Alphaの方が動きの複雑な動画が得意そうだね!

Runway Gen-3 Alpha Turbo を使った動画作成の具体的な手順

Runawayの公式ホームページは英語なので翻訳が必要な場合は、ブラウザの日本語翻訳機能を利用して日本語表示にしてみてください。

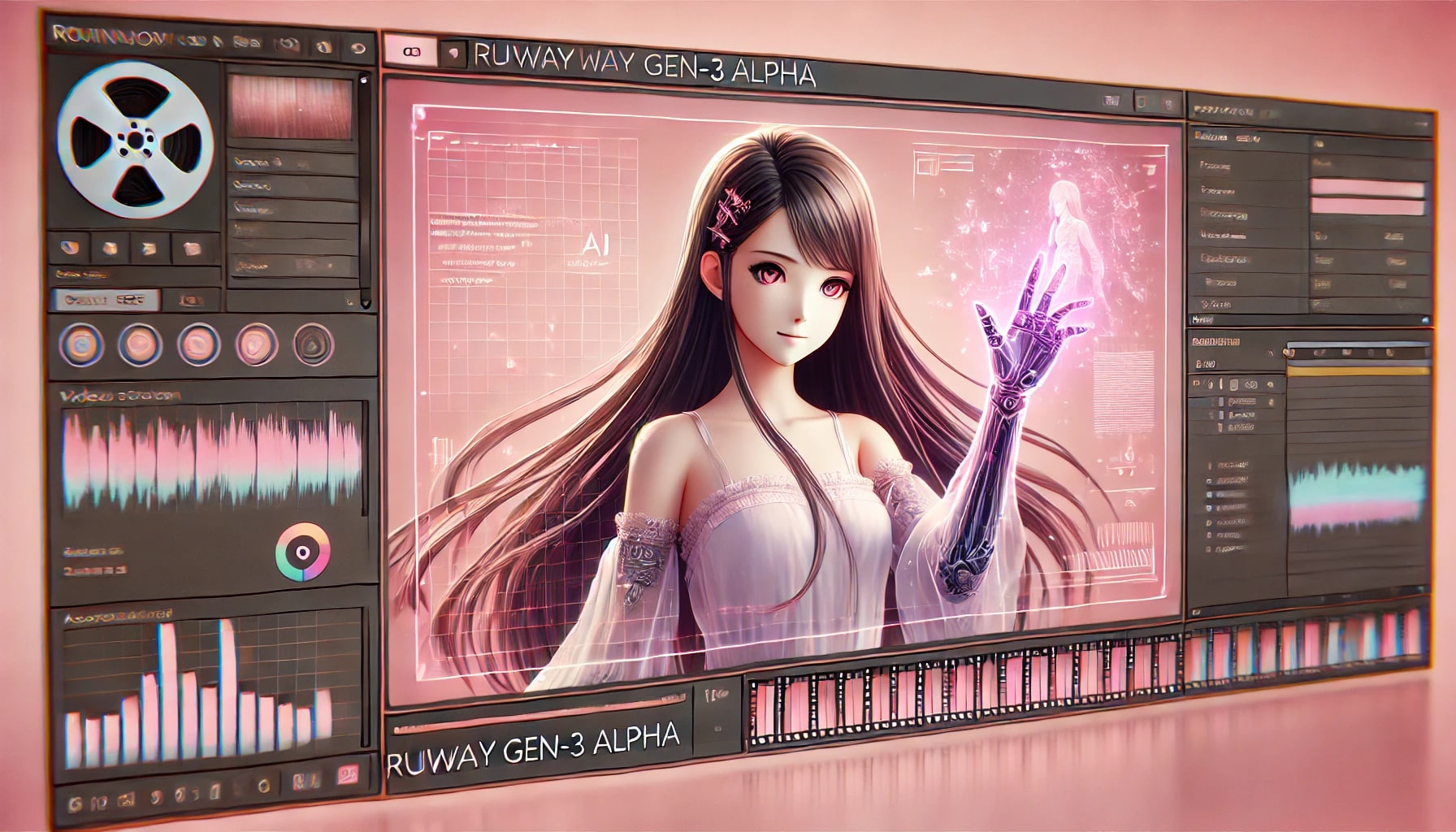

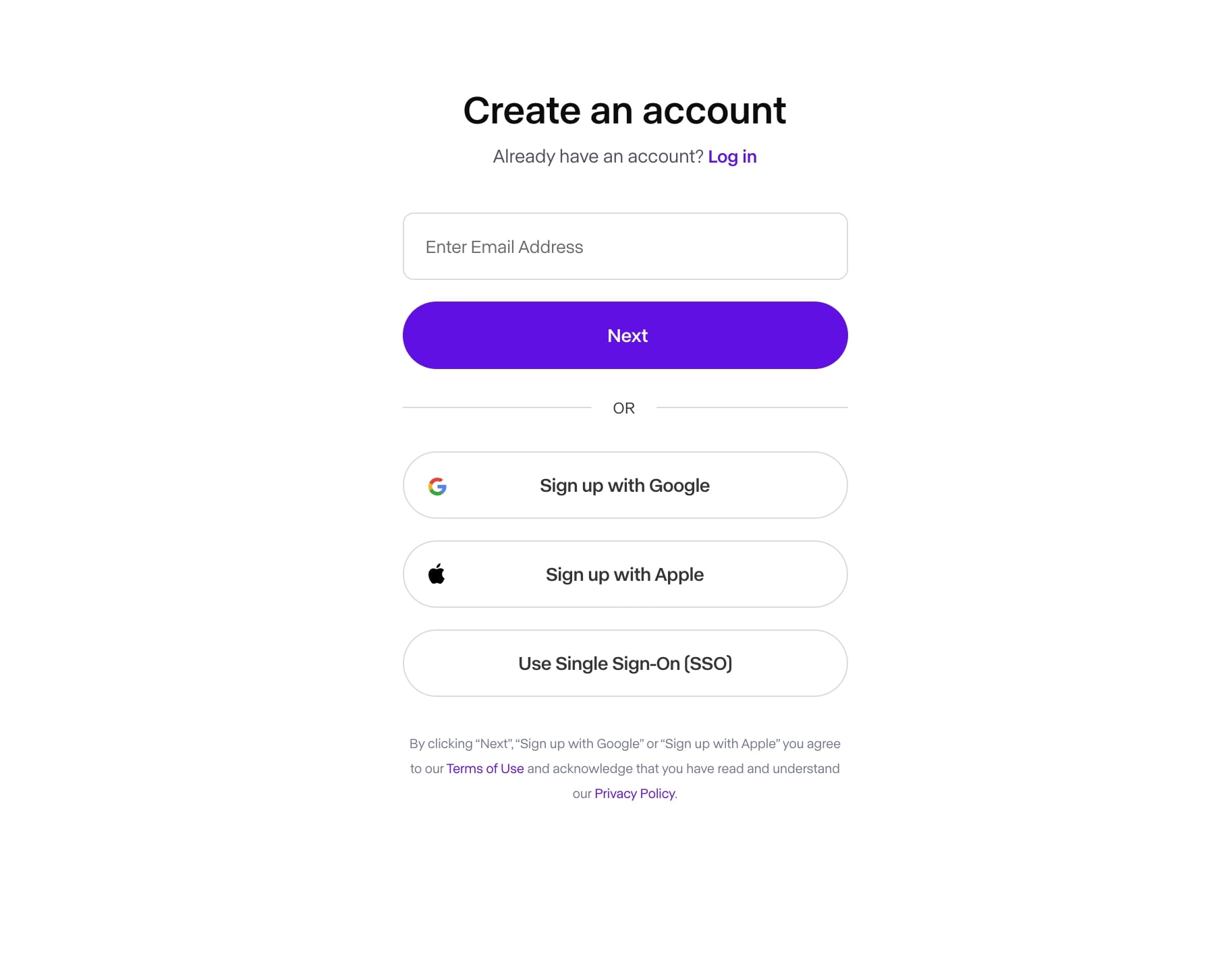

アカウント作成と初期設定

Runwayは、メールアドレスの登録のみで簡単に始めることが出来ます。無料版でもある程度利用できるので、早速アカウントを作成してみましょう。

Emailアドレスで登録するか、もしくはGoogleアカウントやAppleアカウントで簡単に登録できます。

画像から動画への生成手法

前セクションで解説した特徴の通り、画像から動画を生成できるので、DALL-E3やStable Diffusionなどの画像生成AIで生成した画像を使って、そこから動画を生成することが出来てしまいます。

主な特徴

・アウトプットは、1280×768ピクセルの固定解像度

・動画の尺は、5秒また10秒を選択可能

・カスタム設定(プリセット可能)

・リップシンク機能

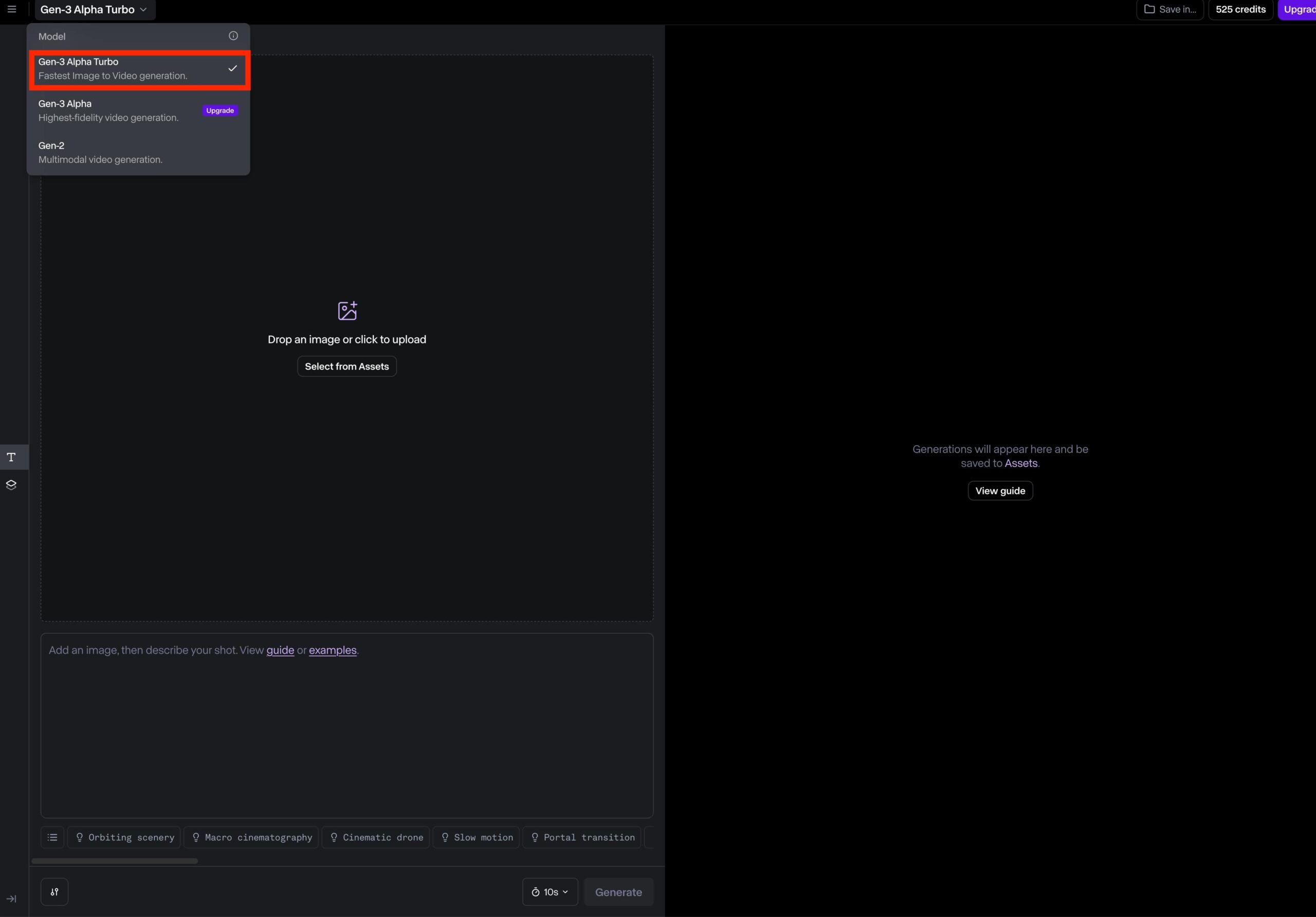

ダッシュボード画面から「text/image to video」を選択します。

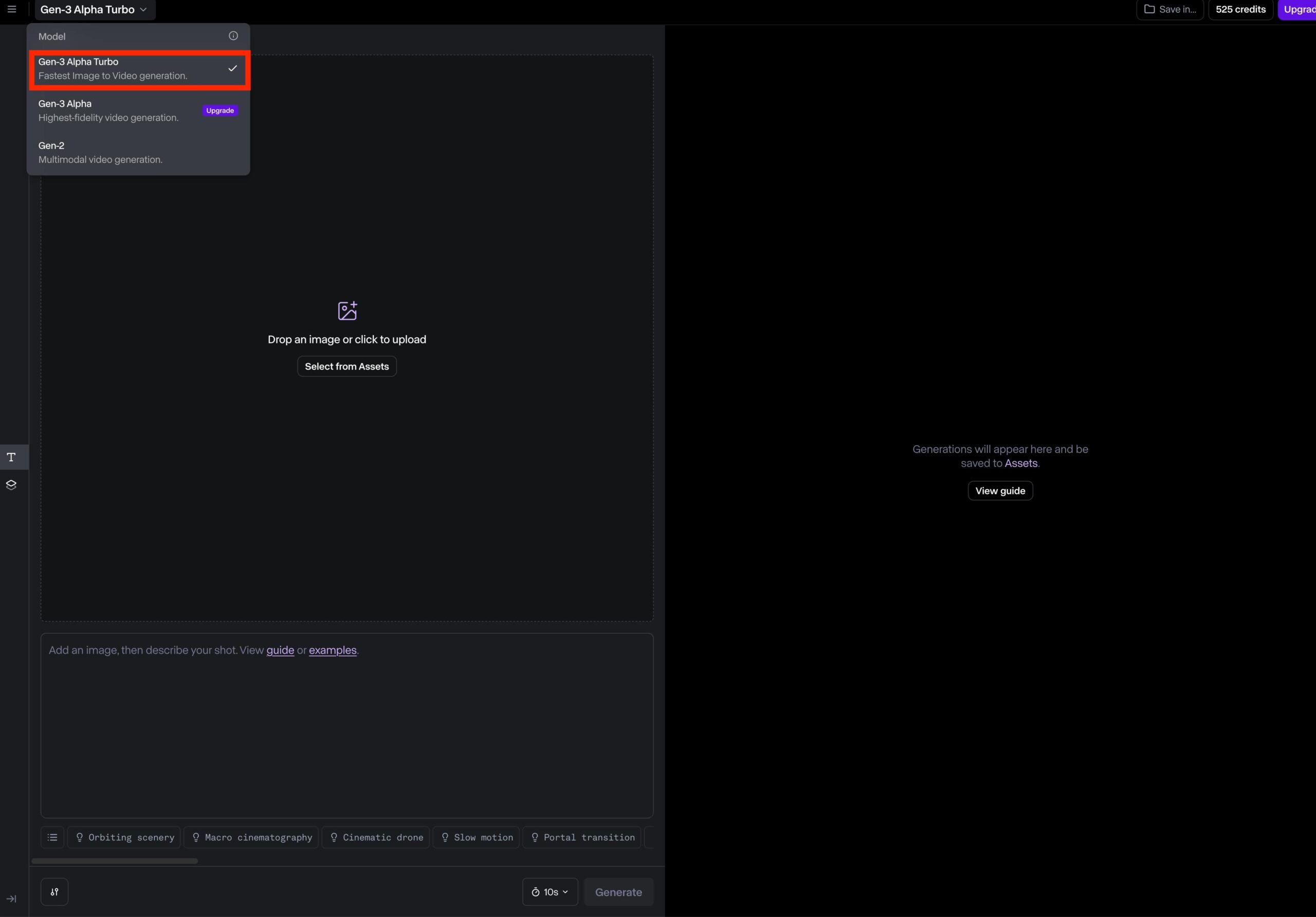

画面左上で、3つのモデル、Gen-3 Alpha Turbo, Gen-3 Alpha, Gen-2を選択できるのですが、無料版では、Gen-3 Alpha TurboもしくはGen-2のみ選択できます。

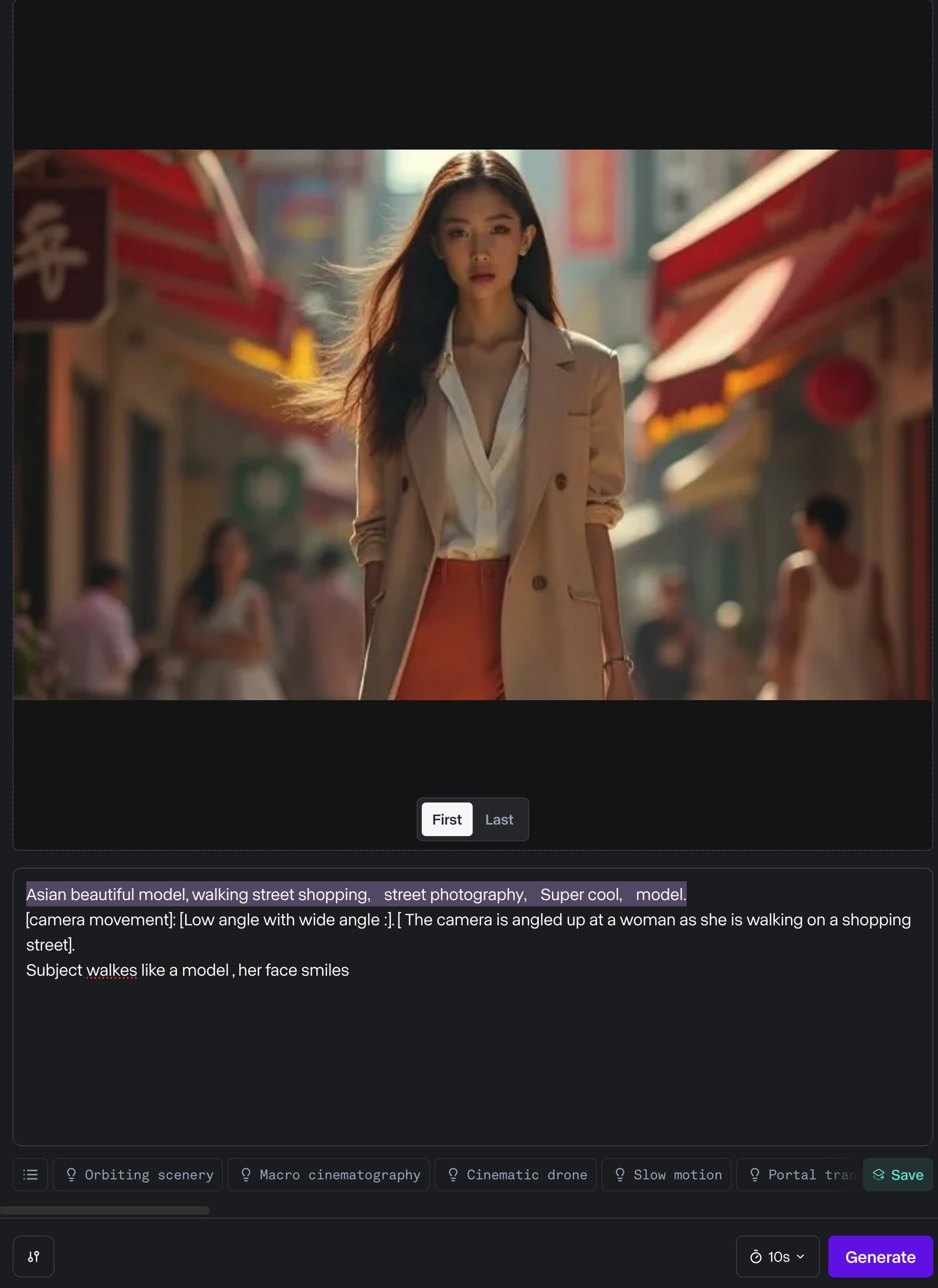

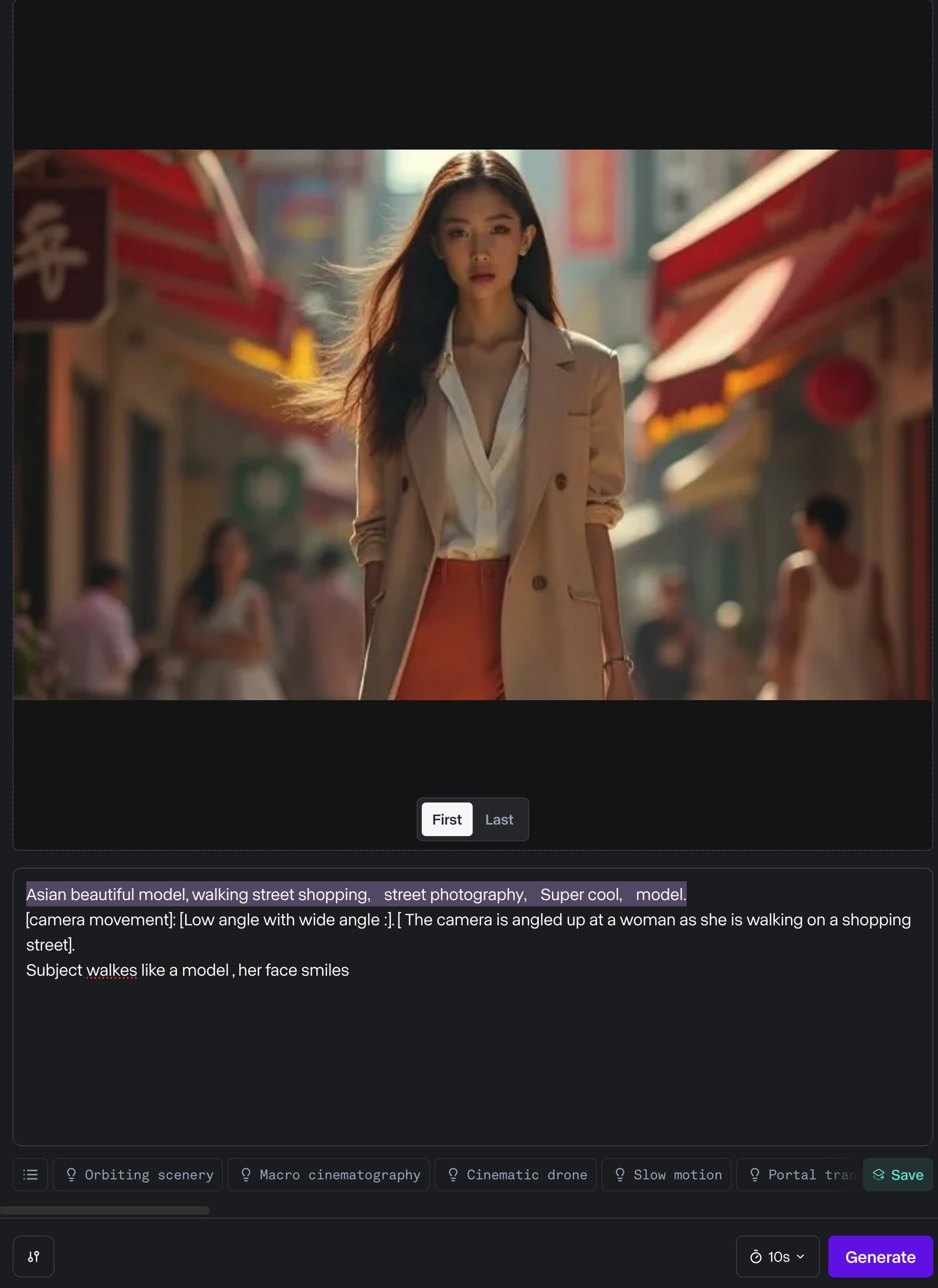

画面左側にアップロードしたい画像をドロップすることでアップロードできます。

「First」「Last」は、画像を動画の最初のフレームにするか、最後のフレームにするかを選択できます。

プロンプト入力ボックスがあるため、そちらに適切なプロンプトを入力します

プロンプトを入力したら、右下の「Generate」ボタンをクリックします。

Asian beautiful model, walking street shopping,street photography,Super cool,model.

[camera movement]: [Low angle with wide angle :]. [ The camera is angled up at a woman as she is walking on a shopping street].

Subject walkes like a model , her face smiles

Gen-3 Alpha Turboは、驚くほど生成速度が速いです。数十秒で完成します。

完成した動画は、まるでプロが撮影した広告動画みたいな完成度になっています。普通は、動画から画像をクリップするのであれば考えられますが、画像から動画が逆に作れてしまいました。

画像が動画になるのって、実際やってみると楽しいね!

いろんな画像を動画にしてみたくなるね。

上手く生成するためのプロンプトの書き方や設定

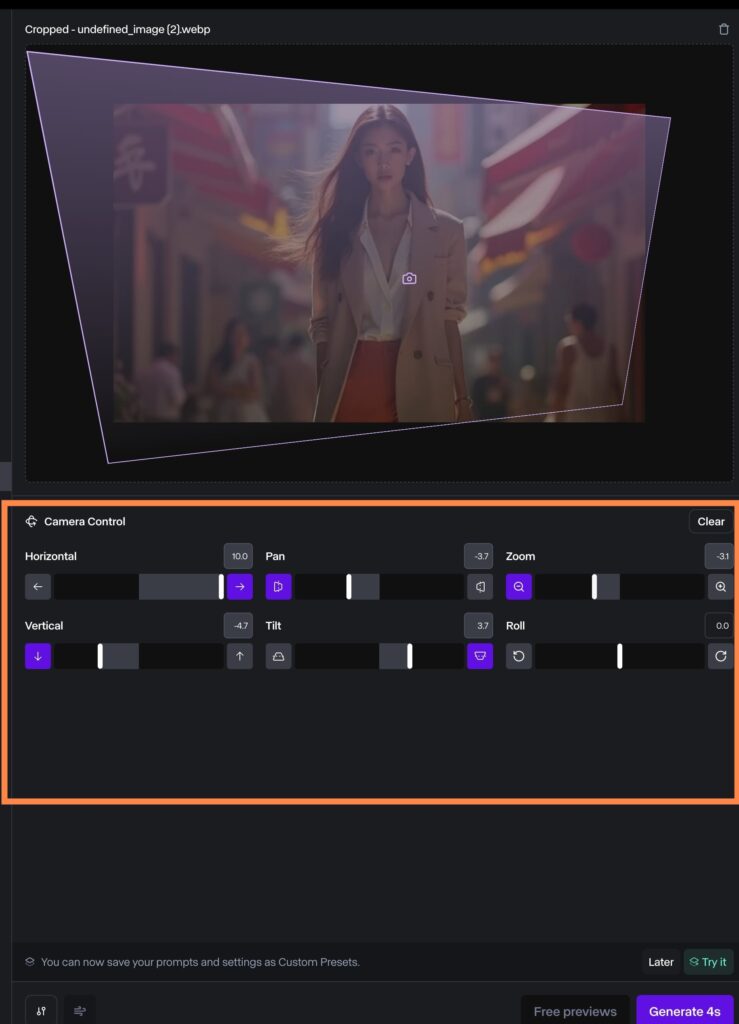

Gen-2のモデルでは、ディレクター・モードがあります。

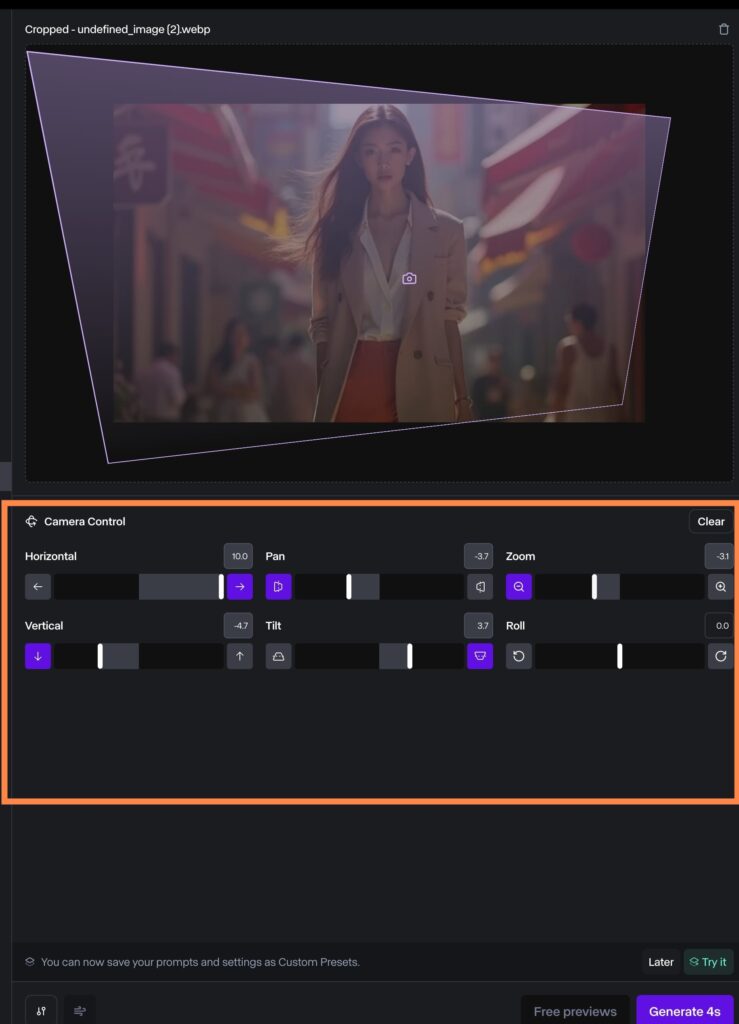

この機能は、下の画像の通りカメラの動き、角度、ズームなどを操作することが出来ます。

これは、他の動画生成AIサイトにはあまりない機能で、出力される動画アウトプットをある程度制御できます。

Runwayならではの機能なのですが、現在のところGen-3ではこの機能はありません。

今後のアップデートでGen-2のディレクター・モードより進化したものが搭載されると発表されているので楽しみですね。

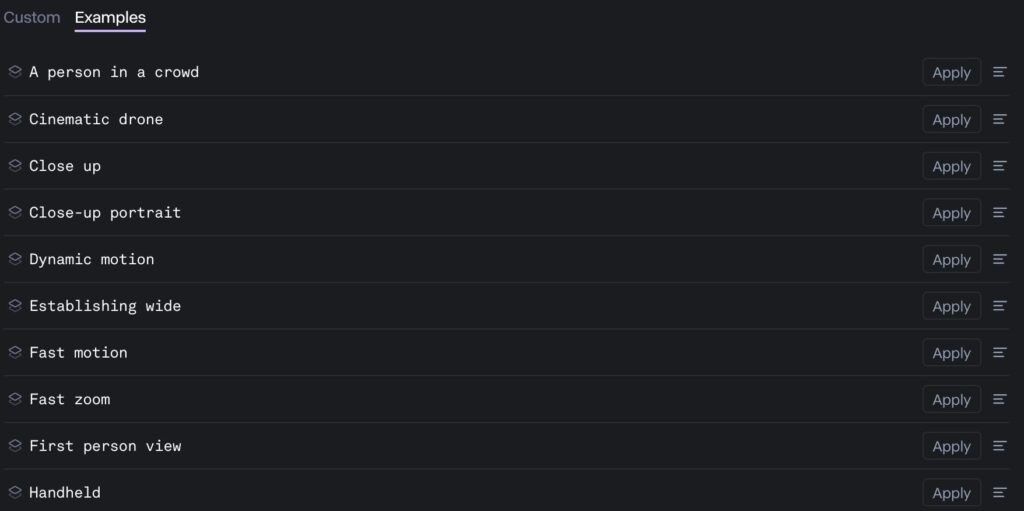

Gen-3では、下の画像の通りカスタム設定ができます。

アップロードした画像の左側のタブで「Custom Presets」を選択することで、カスタム設定を選択し動画生成に適用することが出来ます。

下記の画像の選択肢は、一部でそれ以外にも多くの選択肢があリます。

- 人混みの中の人

- シネマティックドローン

- クローズアップ

- クローズアップポートレイト

- ダイナミックモーション(動きのあるモーション)

- 広角

- 速いモーション

- 速いズーミング

- 一人称視点

- 手持ちカメラ風

FPV(一人称視点)なんかとても面白いですよね。動物や虫などの一人称視点の動画を生成出来ます。

下のRunwayRunwayのXの投稿では、ハイパーラプスとPOVを組み合わせて面白い動画を生成しています。

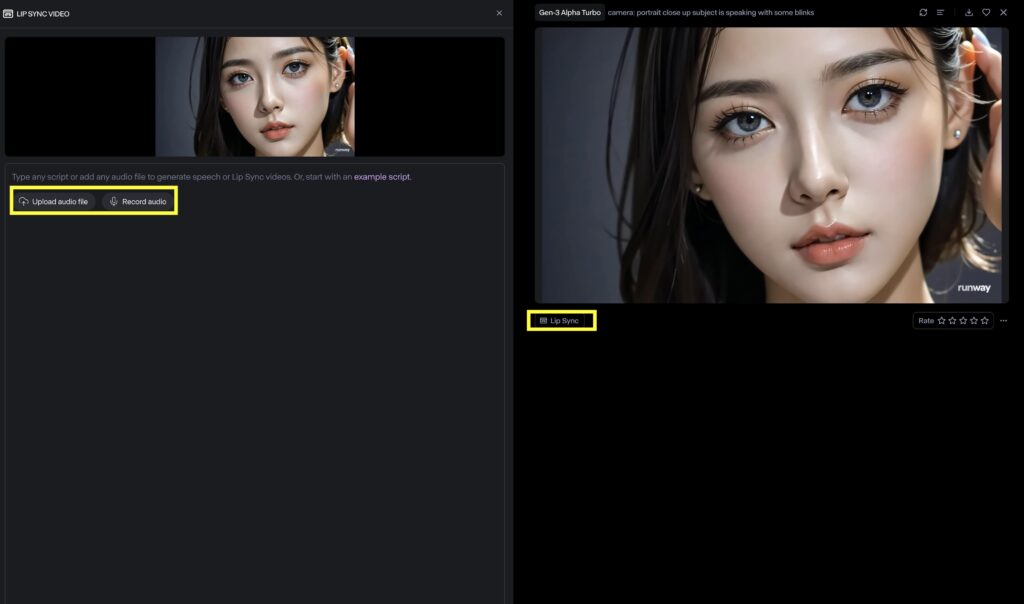

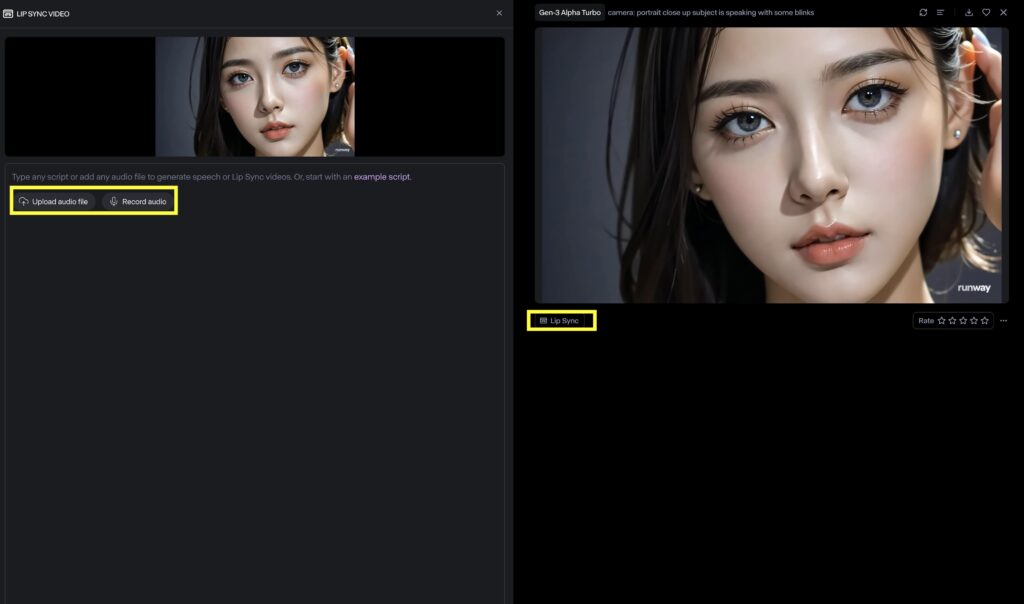

Lip sync(リップシンク)機能

リンプシンク(リップ・シンクロナイゼーション)は、動画内の口の動きと映像の音声が一致している状態を言います。

動画生成後に画面右側の動画の下に表示される「Lip Sync」ボタンを押すと、左側半分が編集画面に切り替わります。

そこで音声ファイルをアップロードするか録音することで音声をシンクさせることが出来ます。

プロンプトのコツとクリエイティブな例

基本的なプロンプトの書き方

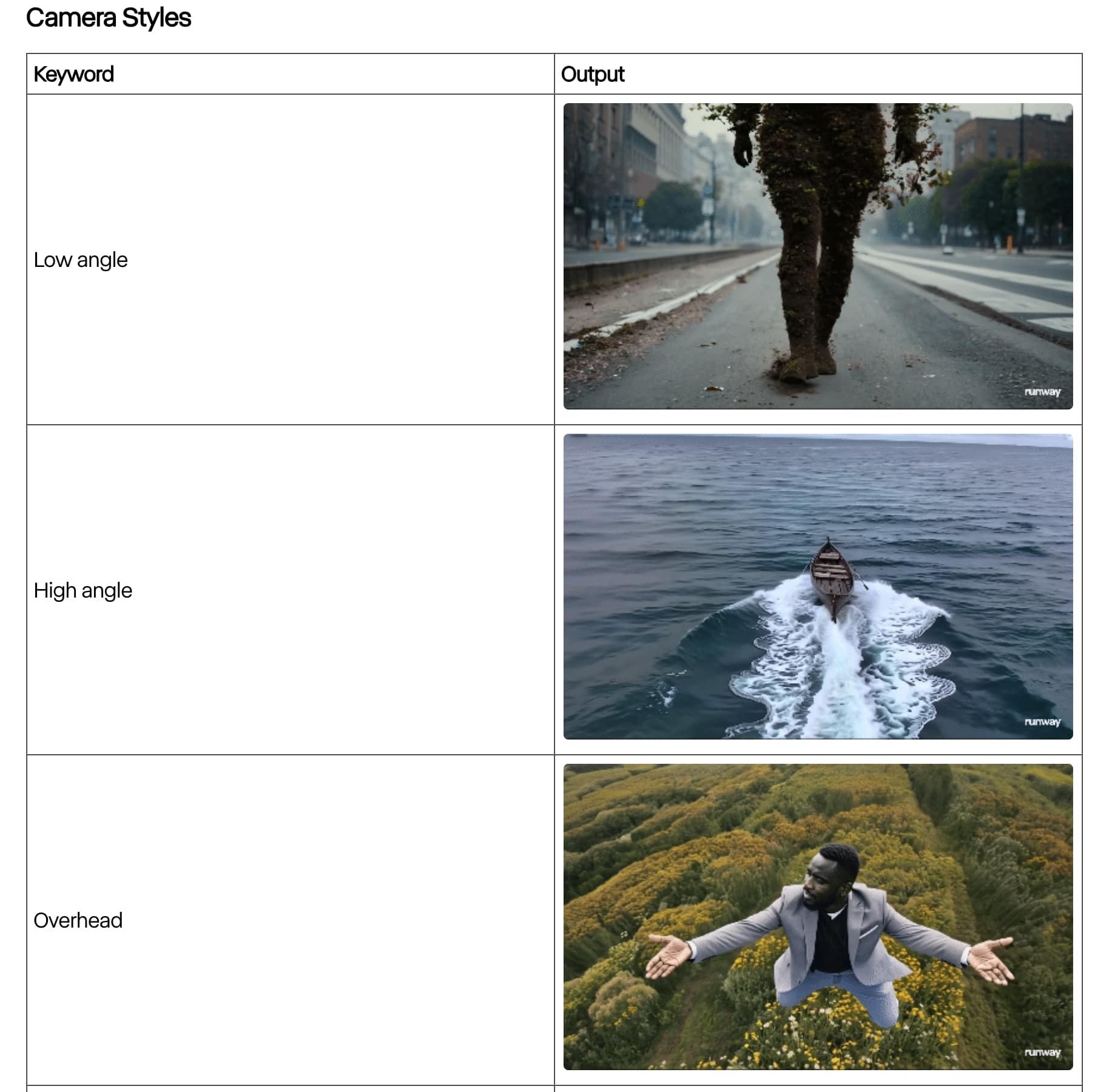

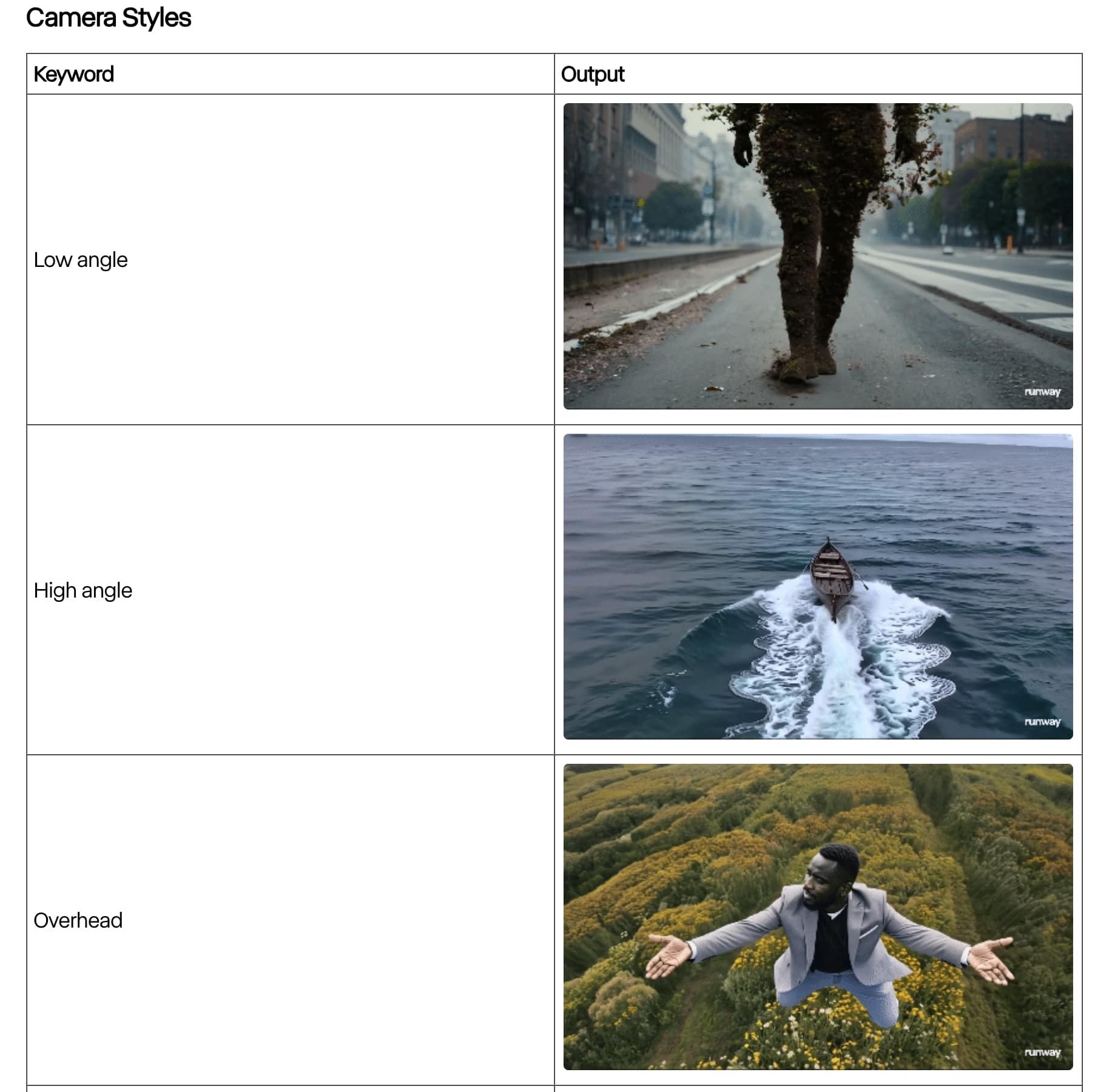

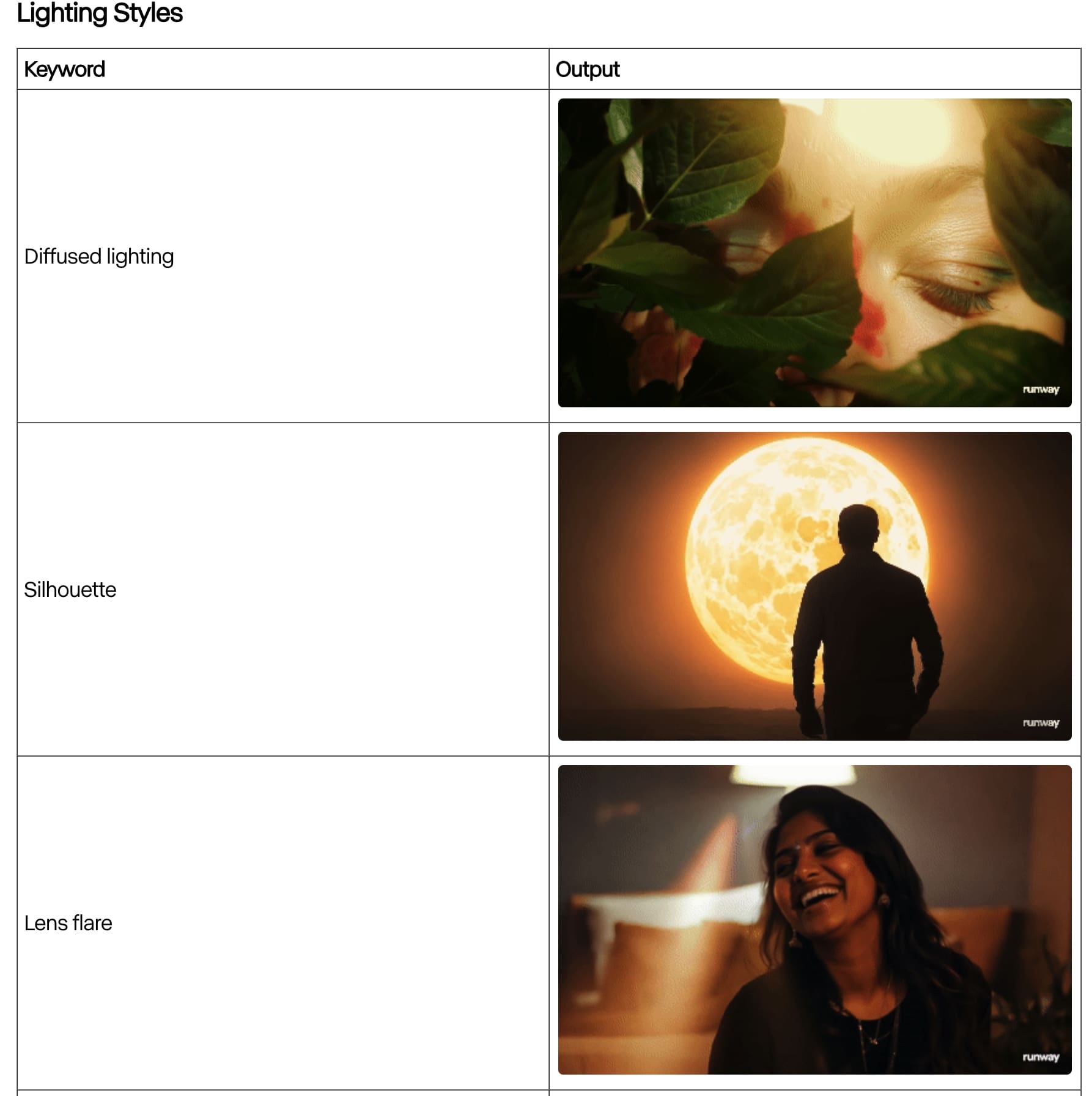

Runway公式ホームページプロンプトガイドラインにプロンプトの構造やキーワードなど、動画をより効果的に生成するためのプロンプト作成のコツが記載されています。

プロンプトの構造

シーン、被写体、カメラの動きに関する詳細を別々のセクションに分けて構造化する

Text to videoは、有料版のGen-3 Alphaモデルのみ可能です。

[Camera movement(カメラの動き)];[Establishing scene(シーンの動き)].[Adiditional details(追加の詳細)]

カメラの動きを指定した後は、セミコロンでシーンの動き指定の以降はピリオドで終えます。

例:[Handheld];[A fashionable woman walking].[at the central park in New York city].

訳:[手持ちカメラ];[おしゃれな女性].[がニューヨークシティのセントラルパークで歩いている].

下の動画がそれで出力した動画です。歩き方が少しぎこちなくなってしまいましたが、手持ちカメラで撮影したカメラワークになっています。

画像の内容よりも、出力される動きについて説明することに焦点を当てる

プロンプトキーワード

- Low angle(ローアングル、下からのアングル)

- High angle(ハイアングル、上からのアングル)

- Overhead(頭上からのアングル)

- FPV(一人称視点)

- Handheld(手持ちカメラ風)

- Wide angle(広角)

- Close up(クローズ・アップ)

- Macro cinematography(マクロ視点のシネマトグラフィ)

- Over the shoulder(肩から上の視点)

- Tracking(追跡視点)

- Establishing wide(ワイドな動き)

- 50mm lense(50ミリレンズ)

- Snorri Cam(被写体にカメラを吊るす器具を使ったショット)

- Realistic documentary(リアルドキュメンタリー風)

- Camcorder(ハンディーカメラや手持ちでの自撮り風)

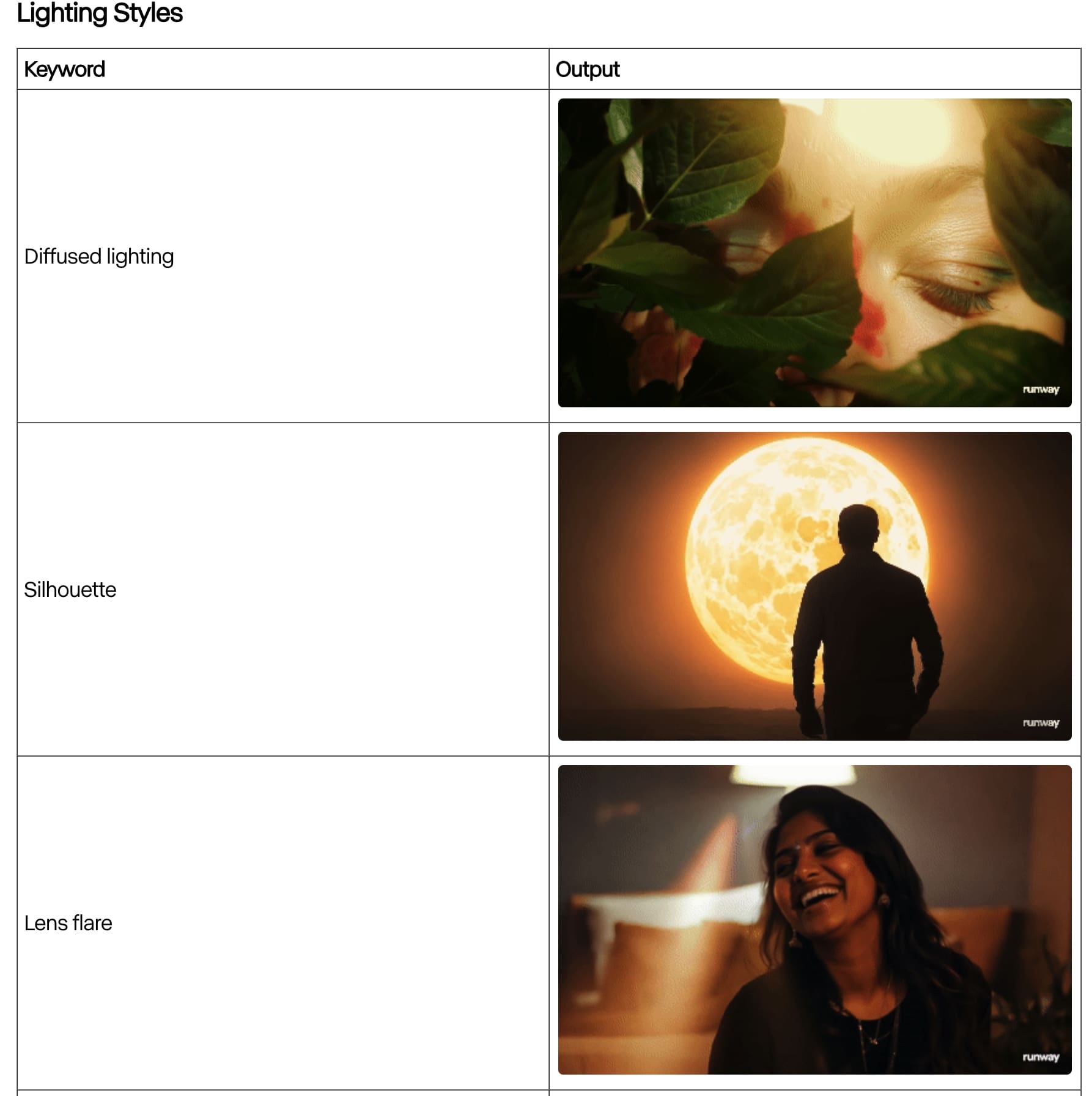

- Diffused lighting(拡散照明)

- Silhouette(人や物体のシルエット)

- Lense flare(レンズのフレア)

- Back lit(逆光)

- Side lit(側面光)

- [Color] gel lighting(色彩・ジェル照明)

- Venetian lighting(ベネチア風ライティング 差し込む灯り)

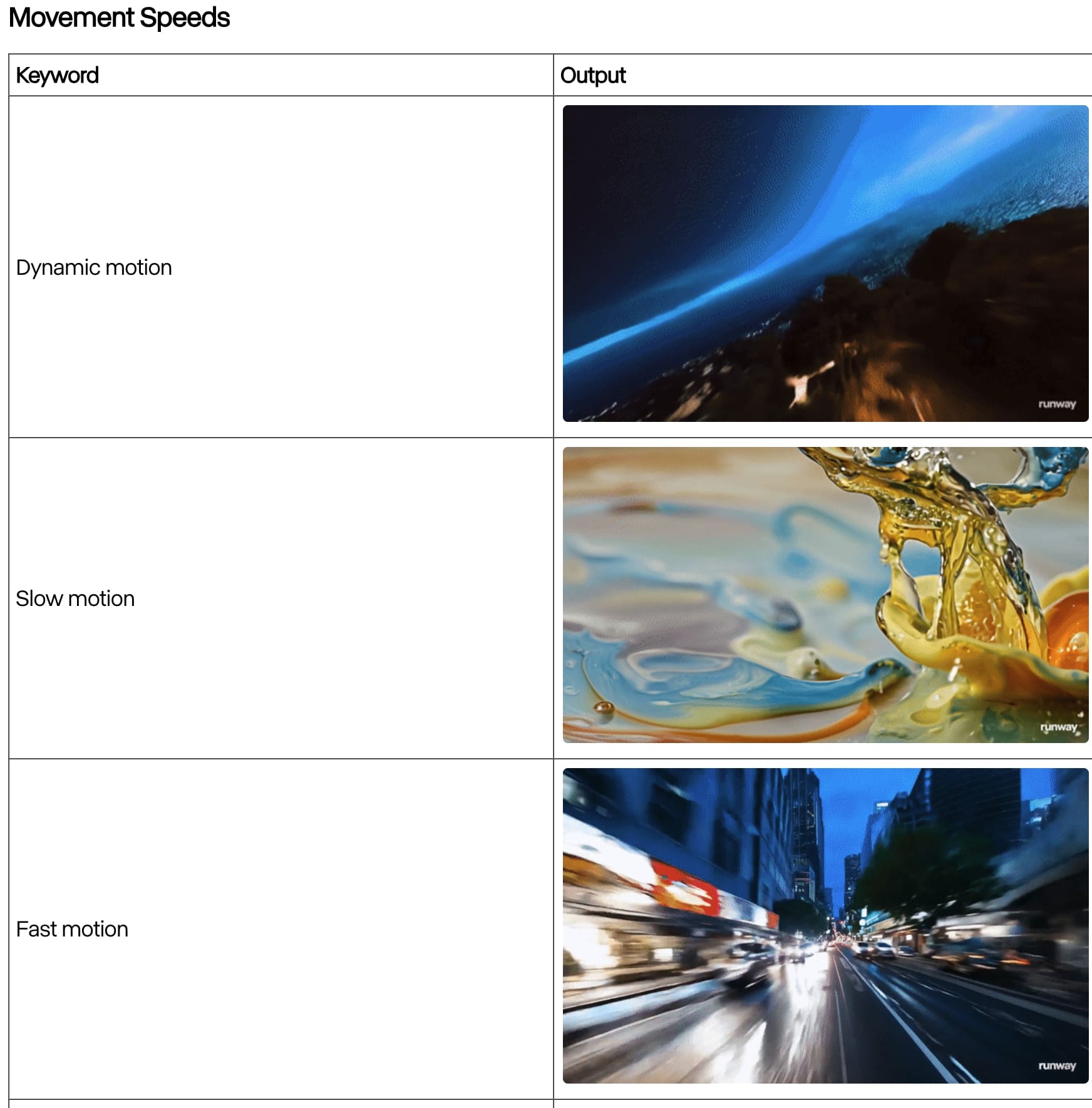

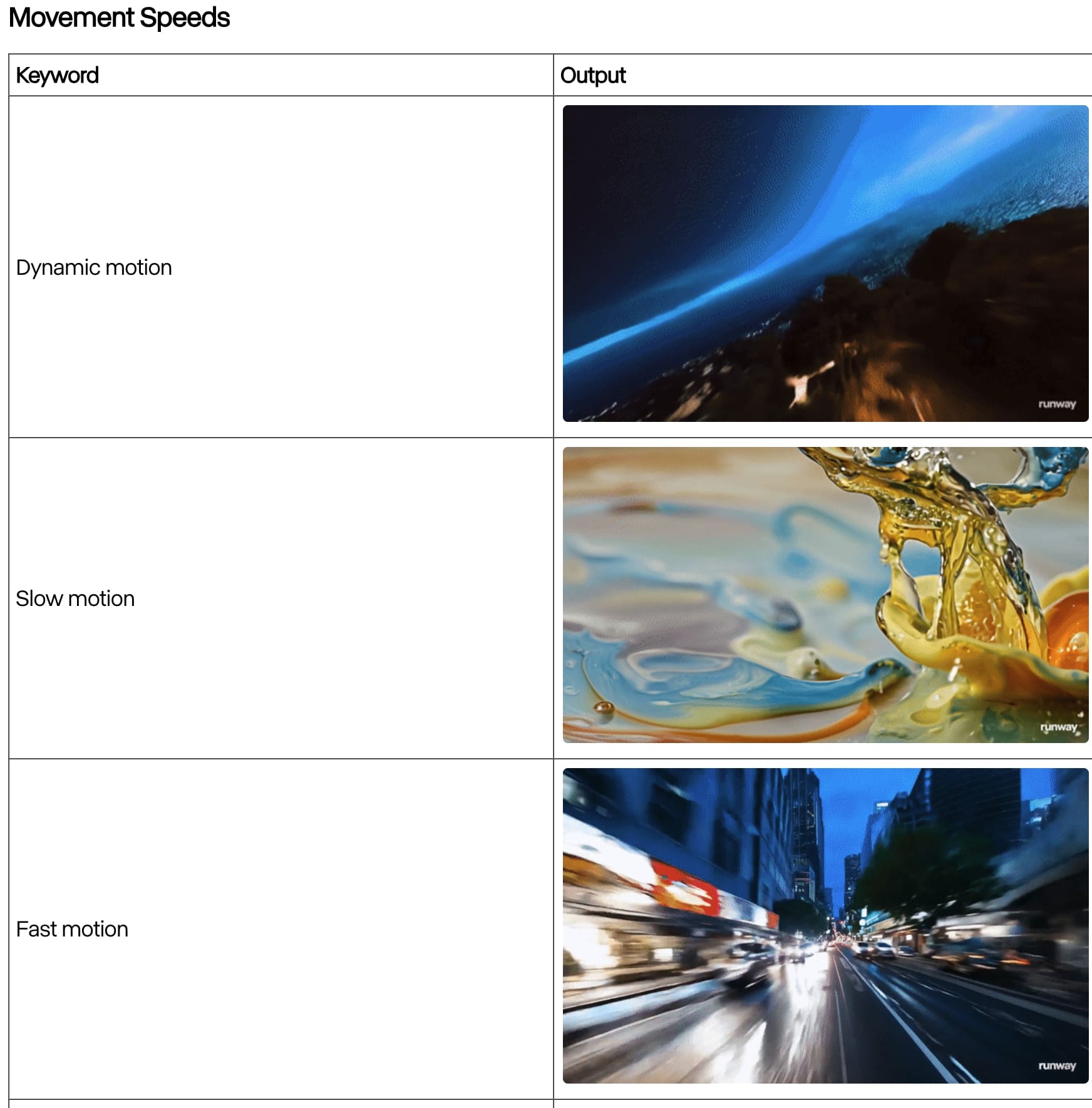

- Dynamic Motion(ダイナミック・モーション)

- Slow Motion(スロー・モーション)

- Fast Motion(ファースト(速い)・モーション)

- Time Lapse(タイムラプス)

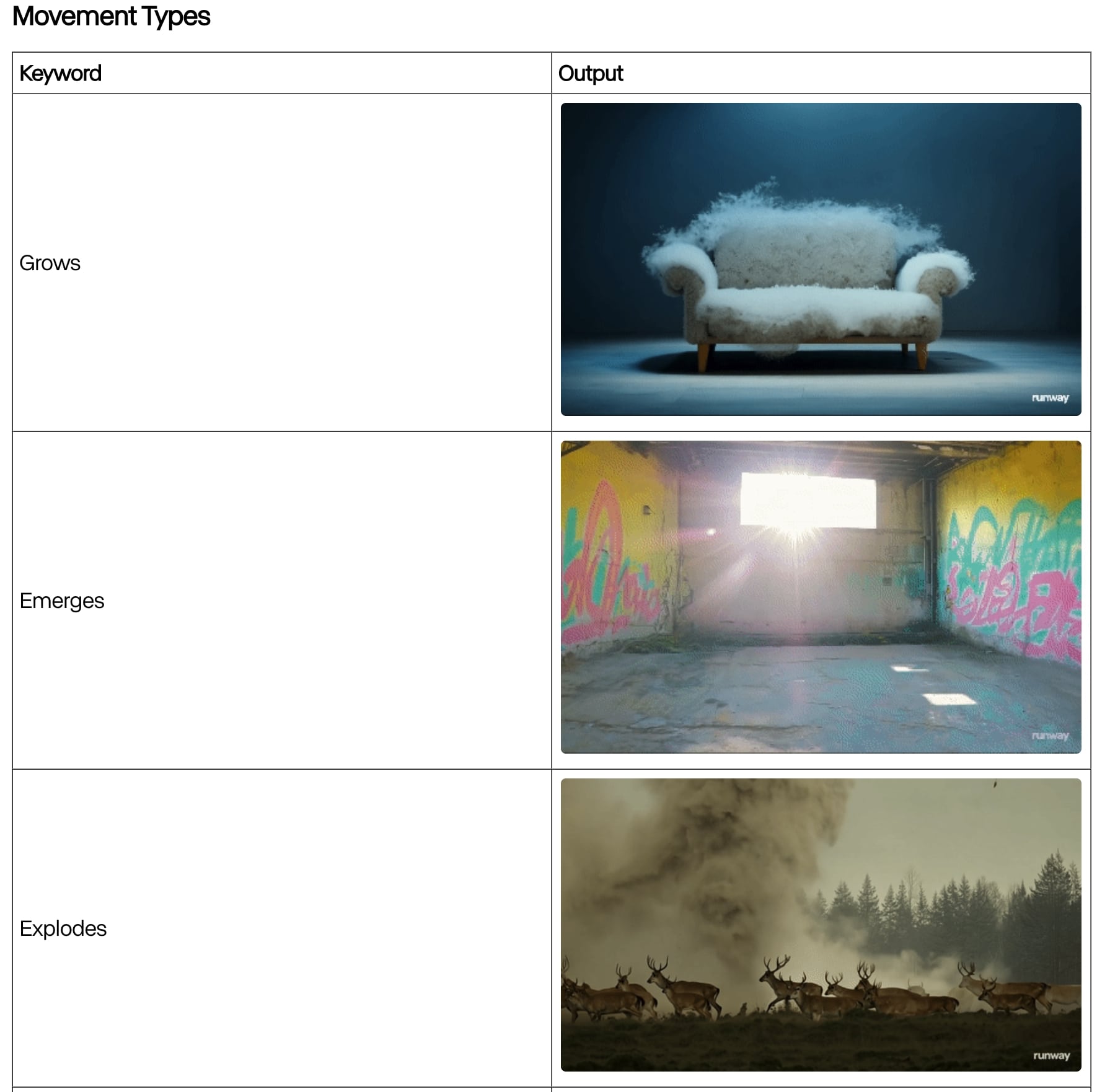

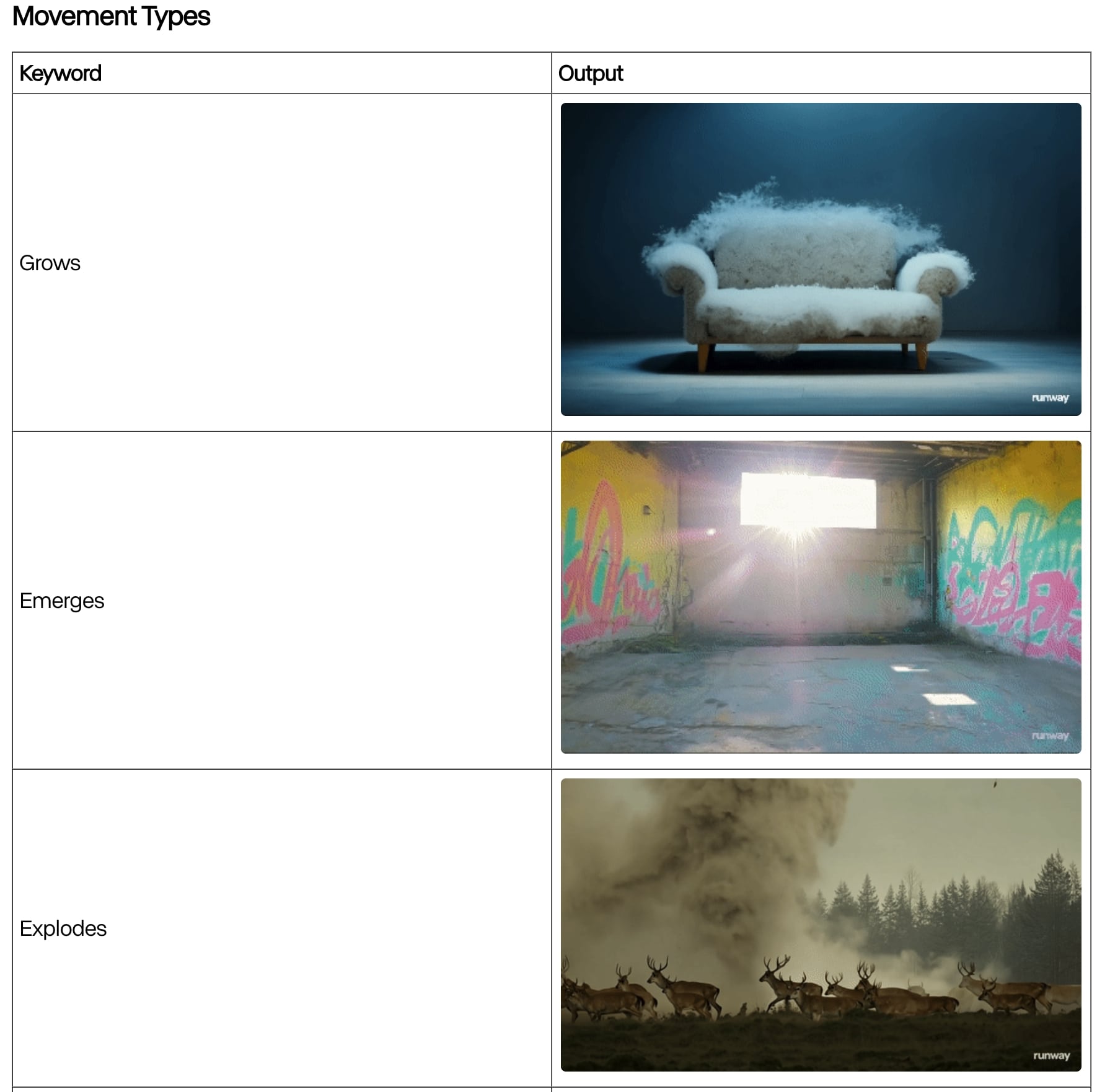

- Grows(成長する、伸びるなど)

- Emerges(出現する)

- Explodes(爆発する)

- Ascends(上昇する)

- Undulates(うねる、波打つ)

- Warps(ねじれる、ゆがめる)

- Transforms(変形させる、変わる)

- Ripples(波紋、さざ波を立てる)

- Shatters(粉砕する)

- Unflods(広げる)

- Vortex(渦巻く)

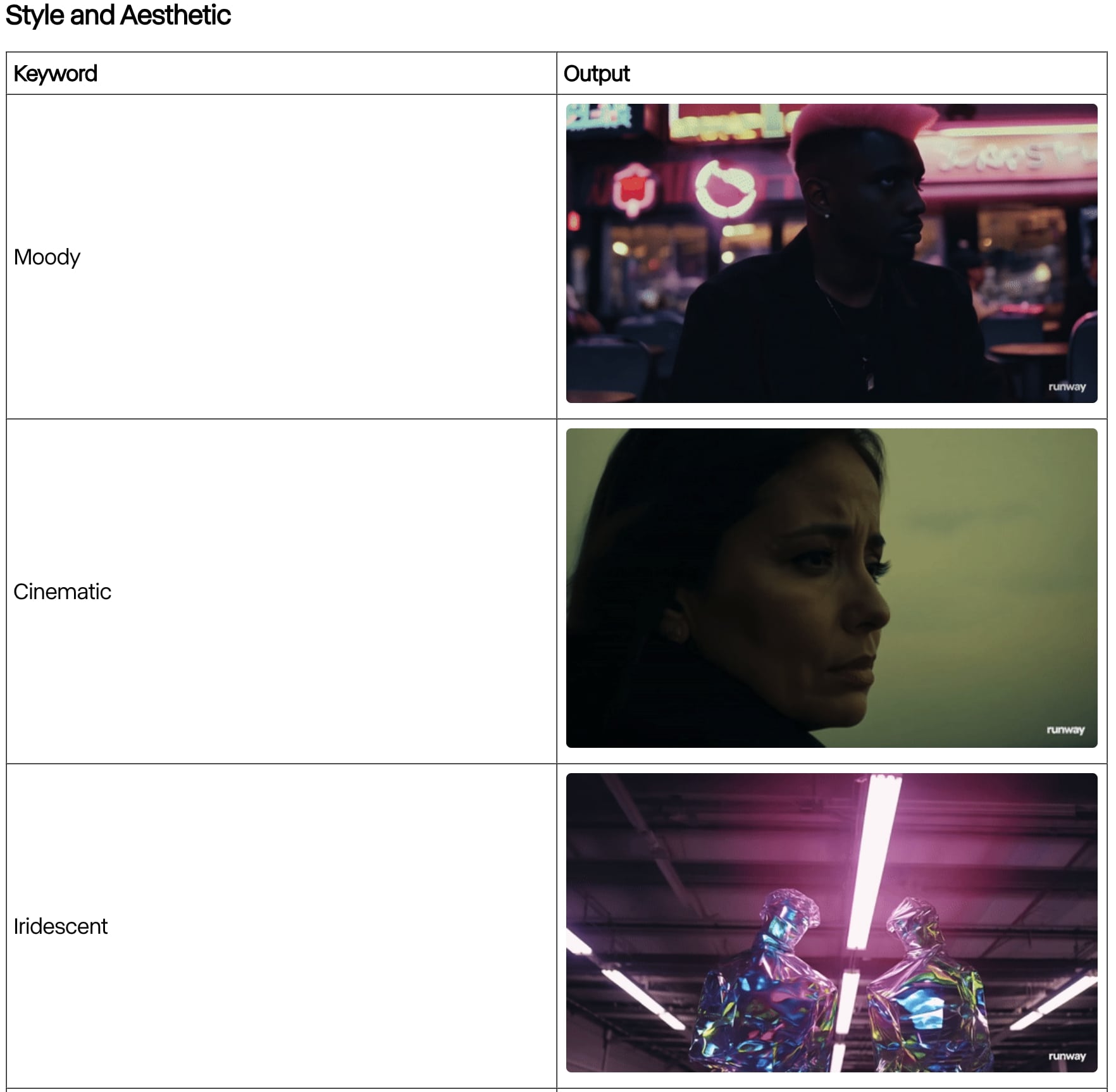

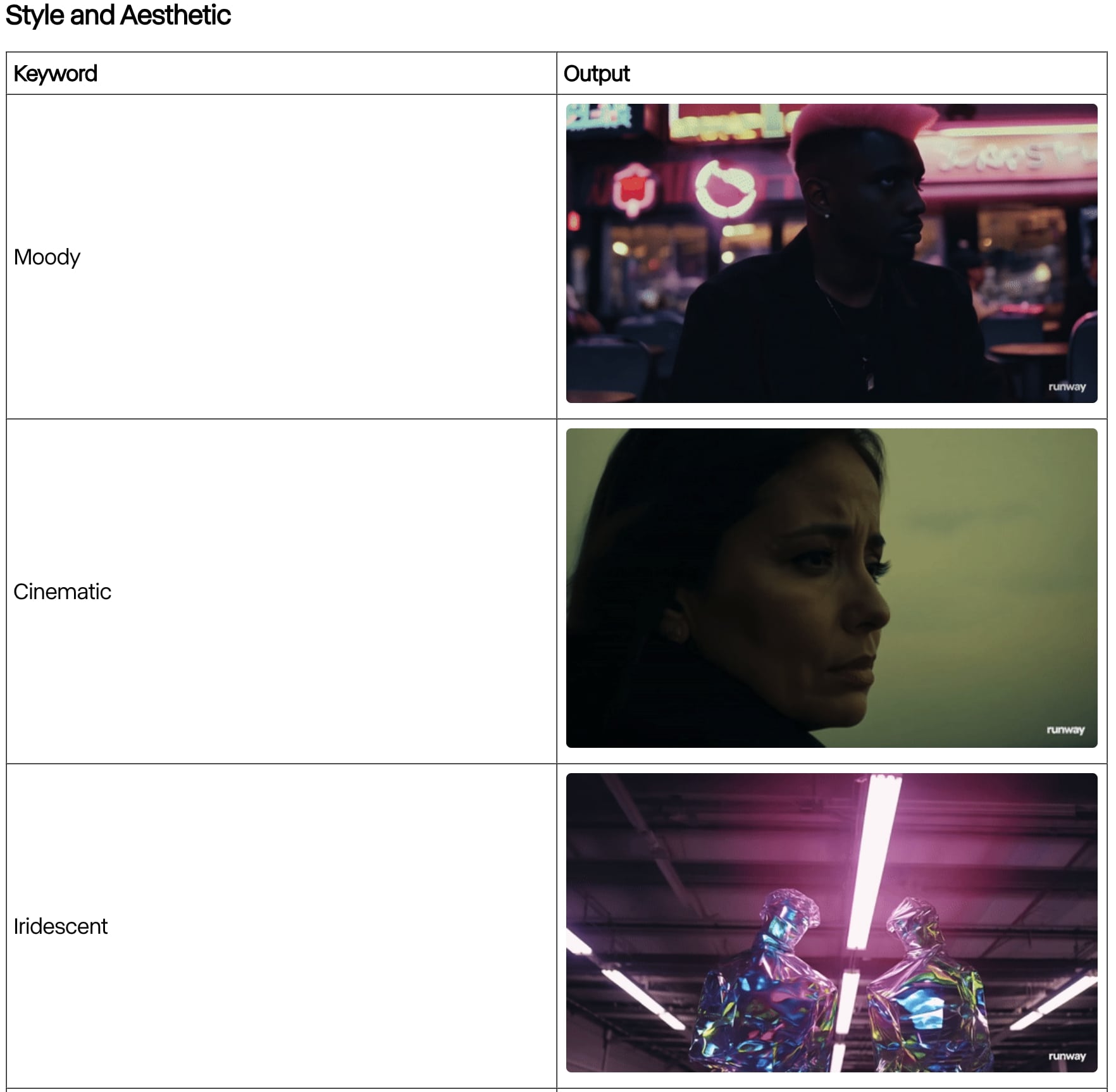

- Moody(ムーディーな)

- Cinematic(シネマティックな)

- Iridescent((光の反射によって)虹色の、色々な色に変化する)

- Home video VHS (VHSホームビデオ風)

- Glitchcore(グリッチコアは、通常の画像を編集して歪め、非常に彩度の高い色や点滅するパターンを含むようにする視覚的な美学)

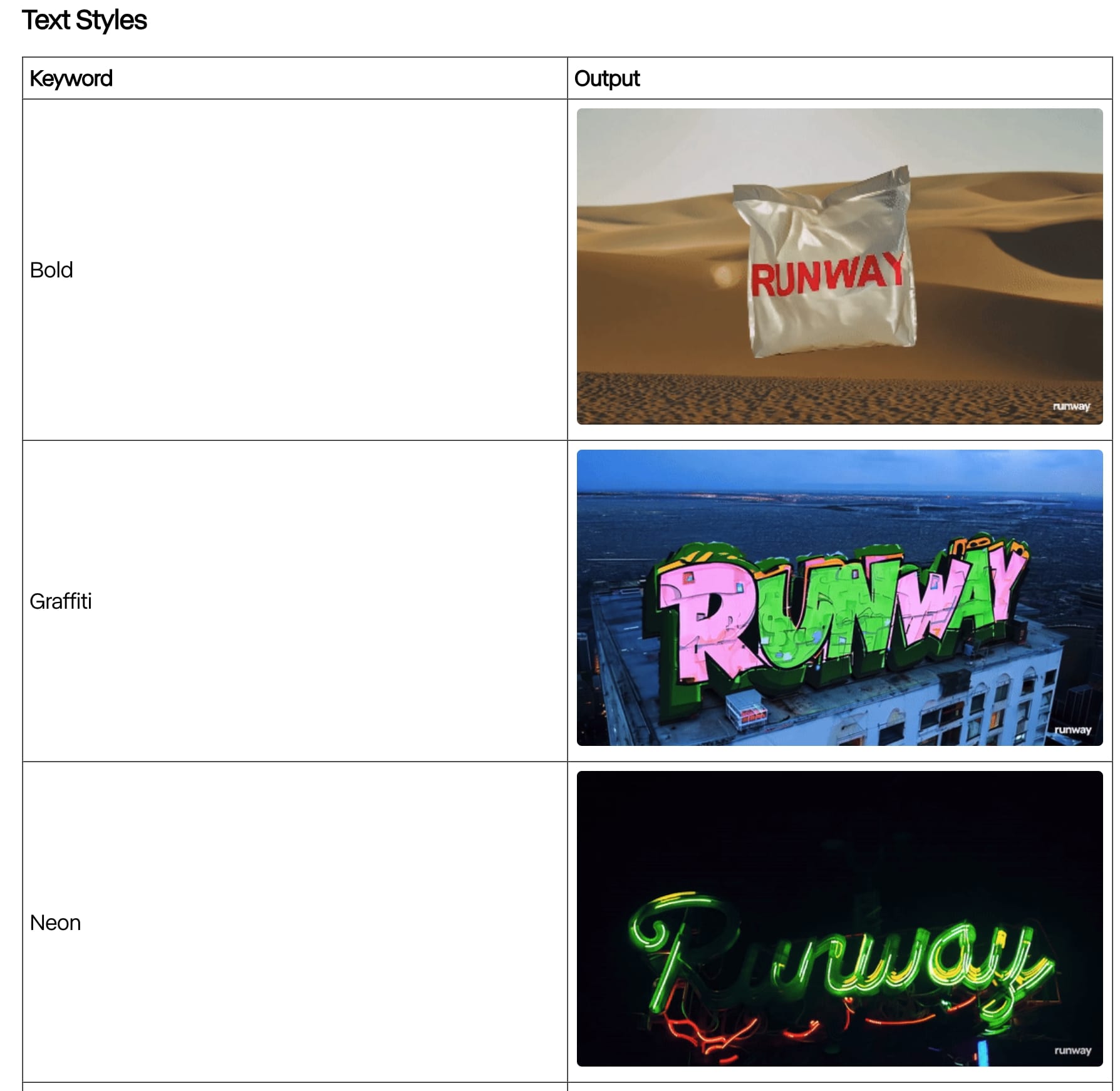

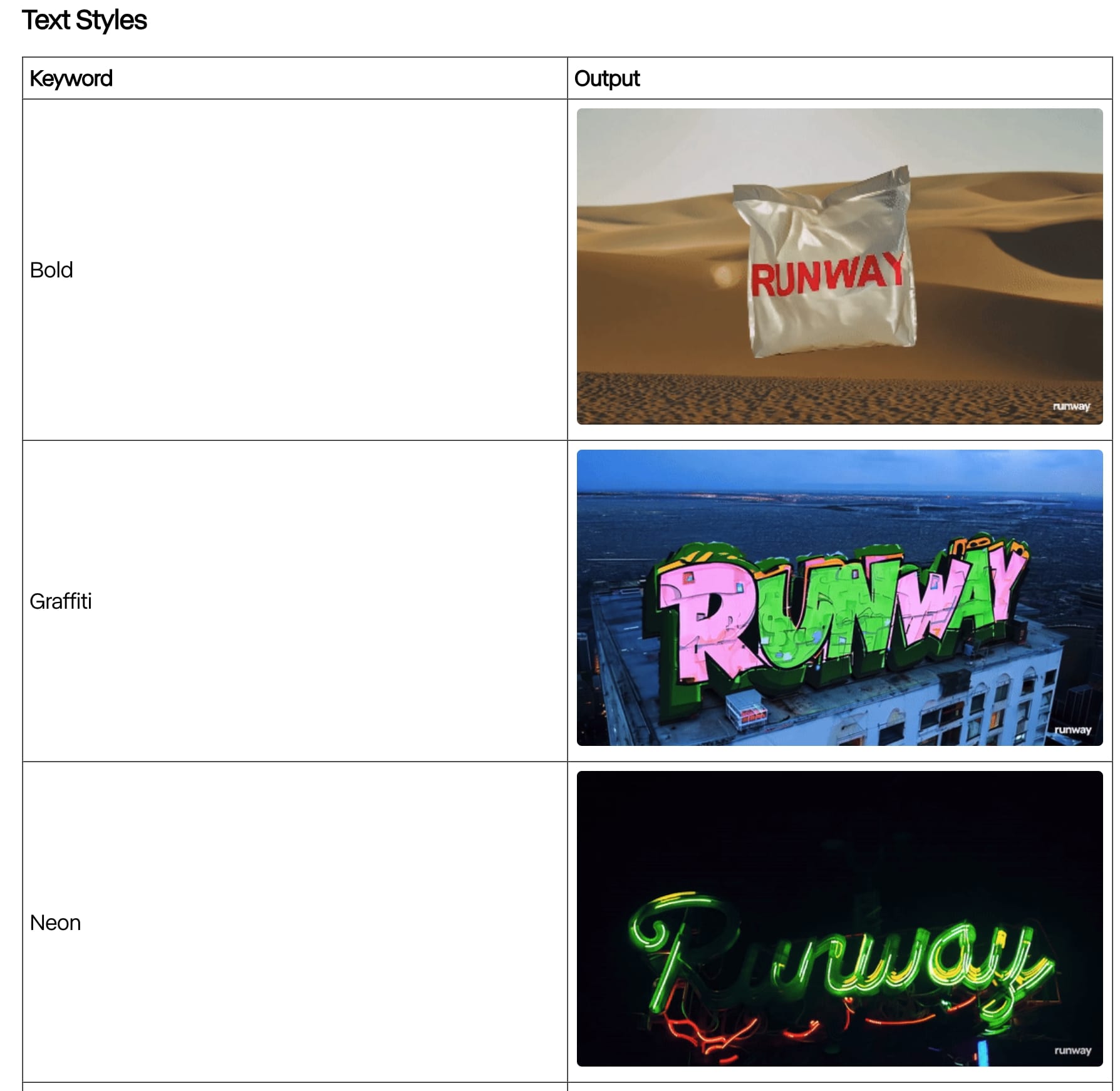

- Bold(太字)

- Graffiti(落書き風)

- Neon(ネオン風)

- Varsity(高校・大学スポーツ代表チーム風)

- Embroidery(刺繍風)

Runway公式ホームページのプロンプトガイドライン

引用元:プロンプトガイドライン

クリエイター必見!生成動画活用事例

通常に撮影した動画のクリップを画像として使用して、生成された動画を元の動画とコンポジット(合成)することでクリエイティブで面白い動画を作ることが出来ます。

いくつか面白い例をご紹介します!

合成したらこんな楽しい動画が作れてしまうなんてね!このレベルの動画を自分で作れてしまうなんてすごすぎる。

Runway Gen-3 Alpha Turbo を使ってみて

Runway Gen-3 Alpha Turboの良い点と欠点

動画生成AIは、Open AIが「 SORA」と名付けた動画生成AIを発表されてそのレベルが過去のもの比べて、レベルが格段に上がってきていることを認識しました。

Open AIの「 SORA」に期待が集まっている中、2024年8月現在も一般公開がされていません。

そこでRunwayがアップグレードしたGen-3がリリースされたことで、現時点ででは、動画生成AIの最有力と言っても過言ではありません。

そこで2024年8月時点で最強動画生成AIである「Runway Gen-3」の強みと弱みをまとめてみました。

- 生成速度がとても速く、数十秒で10秒程度の動画を生成

- 人物の表情が豊かで多様な動作が可能

- 10秒動画でもキャラクターや要素の一貫性を高レベルで維持

- 複雑で詳細な環境や物体を精密にレンダリング

- テキストからだけでなく、画像入力で動画生成可能

- アウトプットにある程度のコントロールが可能(今後のアップデートでさらに細かく制御が可能に)

- 高コスト

- Gen-3には、現時点で動画から動画への生成機能はない

- 動きのない単なる静的なズームだけの動画が生成される場合がある

- 一貫性がよくなりGen -2より改善されてはいるが、顔や表情が動くシーンで顔の特徴を一貫して維持できない場合がある

- 手足の複雑な動きに対して、正確にレンダリングが難しい場合がある

Gen-2からGen-3へバージョンアップしたことで、生成速度が格段と上がり、特に細部の表現、一貫性、動きの表現において大幅な改善が見られます。

2024年8月後半時点では、Gen-2であったディレクターモードがなく、プロント以外で、ユーザーのコントロールがありません。

今後のアップデートで、ディレクターモードもパワーアップしてGen-3に導入される予定とのことなので、期待しています。

Runway Gen-3 Alpha/Turboと画像生成AIのFLUXが最強コンビ!?

FLUX+Gen-3 Alpha Turboの組み合わせが最強!?

画像→動画生成をGen-3 Alpha Turboモデルを画像から動画生成を行う場合、MidJorneyV6でもちろん作成した高画像でも可能ですが、最近Midjourneyを凌駕すると話題の画像生成モデルFLUXを利用して高画質な画像を生成し、その画像を利用して動画を生成することでハイクオリティな動画生成が出来ます!

FLUX.1は、2024年8月にBlack Forest Labs(Stable Diffusionの開発者たちが設立)によって発表されたオープンソースの最新画像生成AIモデルです。主な特徴は以下の通りです:

- 120億のパラメータを持つ大規模モデル

- 高品質な画像生成能力(MidjourneyやDALL-E 3を凌駕すると評価)

- プロンプトに対する高い忠実性

- 3つのバリエーション(pro、dev、schnell)を提供

- 複雑なシーンや細かい指示にも正確に対応

Black Forest Labsはドイツに拠点を置き、最近ステルスモードから出て、Andreessen Horowitzが主導する3100万ドルのシード資金を調達しました。

その他の注目すべき投資家には、Y CombinatorのCEOであるギャリー・タンや、元Oculus CEOのブレンダン・イリブが含まれています。

このスタートアップの共同創設者であるロビン・ロンバッハ、パトリック・エッサー、アンドレアス・ブラットマンは、かつてStability AIのStable Diffusionモデルの開発に携わった研究者でした。

最近では、Eron Maskとのコラボレーションが発表され、XのAIであるGrokの画像生成AIをFlux.1を用いて強化しているそうです。

Techcrunch記事参照

引用元:Meet Black Forest Labs, the startup powering Elon Musk’s unhinged AI image generator

Flux.1には、以下の3つのモデルがあります。

- FLUX PRO:最高品質、商用利用可能

- FLUX dev:非商用向け

- FLUX schnell:生成スピード重視

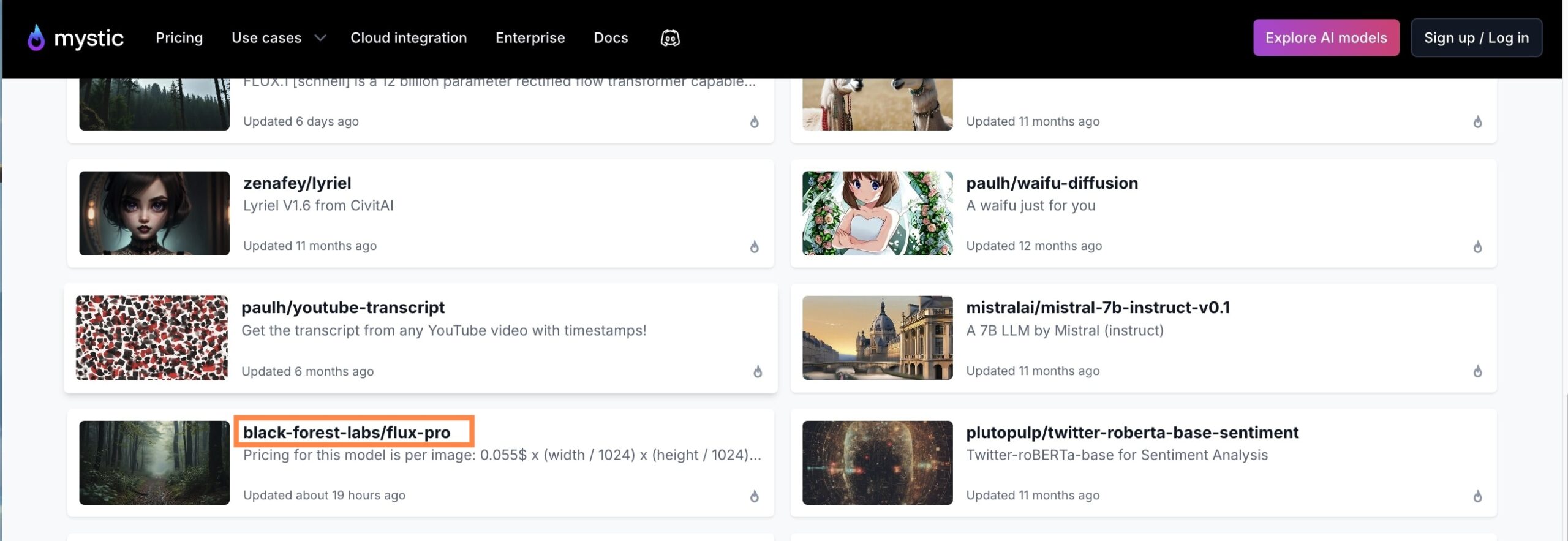

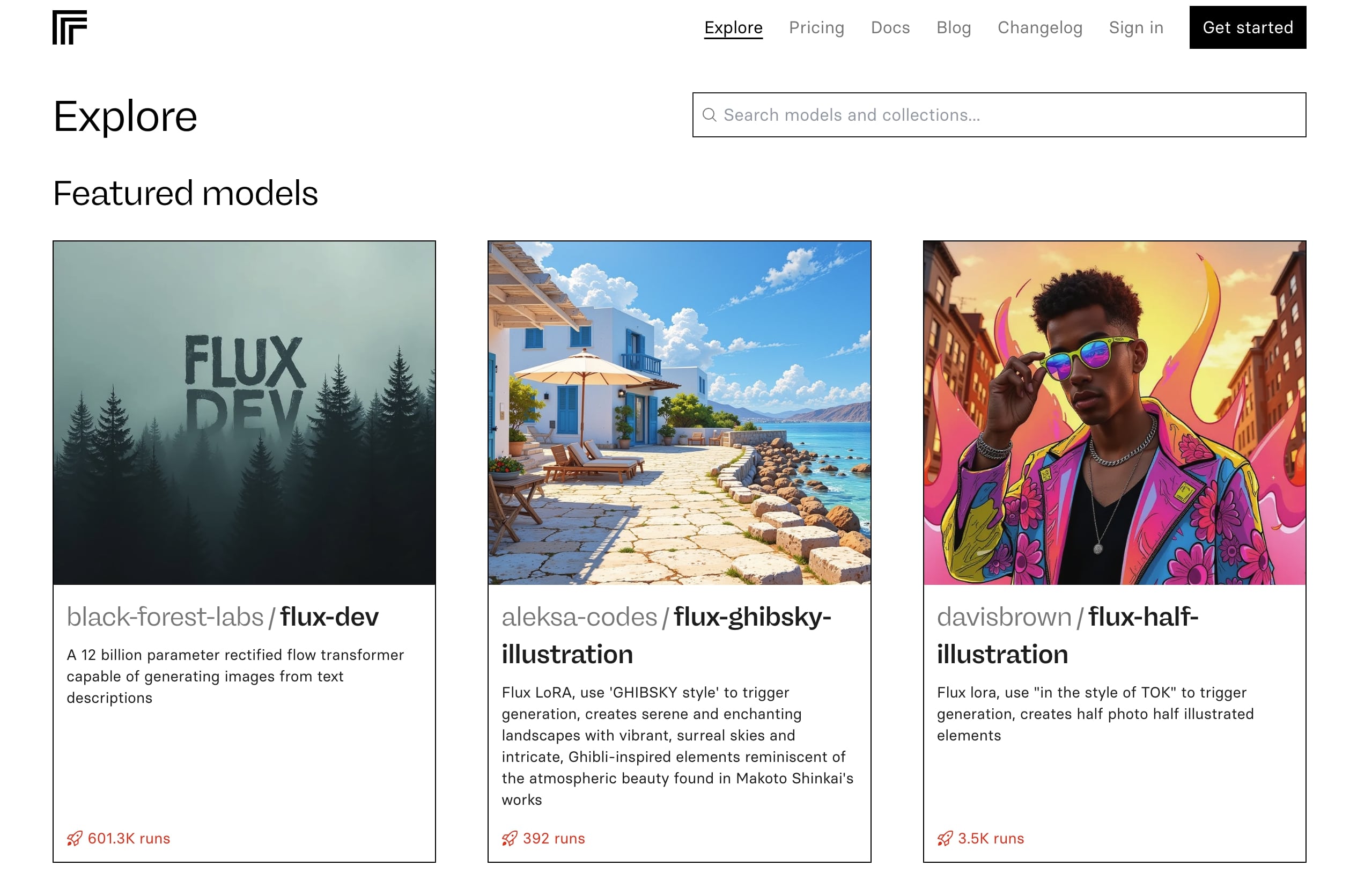

FLUX PROは、2024年8月後半現在では、利用できるサービスプラットは以下の通りです。

- Mystic.ai

-

FLUXのModel Hubで全モデルが利用可能。

引用元:Mystic.aiホームページ:Explore - Replicate

-

Replicateというプラットフォームを通じてFLUX.1 Proを利用できます。GitHubアカウントでのサインインが必要です。

引用元:Replicateホームページ - fal.ai

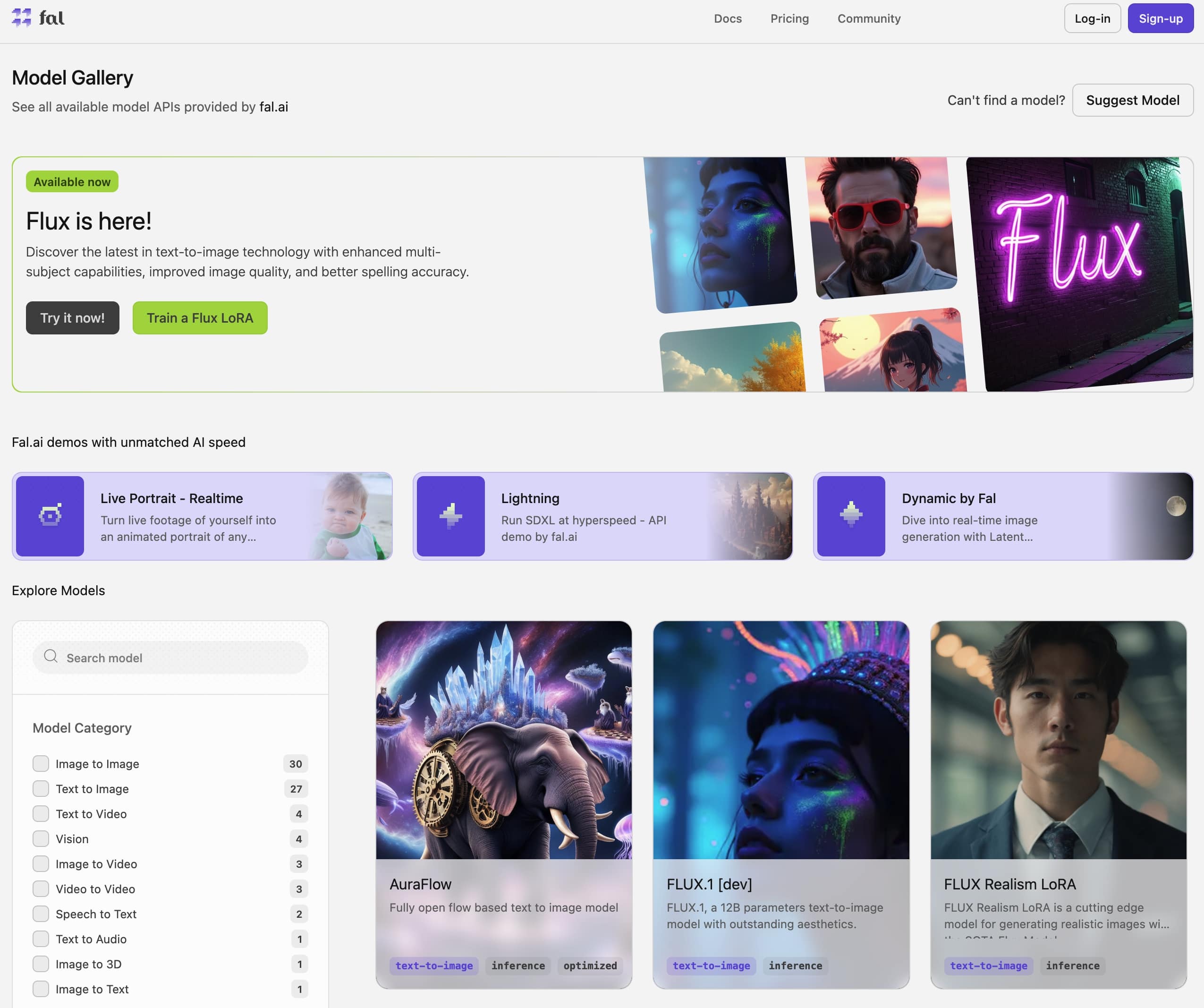

-

fal.aiというプラットフォームでもFLUX.1 Proを利用できます。こちらもGitHubアカウントでのログインが必要です。fal.aiは比較的無料利用枠が多いとされています。

引用元:fal.aiホームページ

もしProでなくても良いから気軽に使ってみたいという方は、BasedLabsがおすすめです。

無料プランでも、FLUX.1 devとFLUX.1 schnellを試すことが出来ます。

パターン1画像:サイバーな女性兵士の画像を生成

パターン2:水が滴った目のクローズアップ画像を生成

パターン1画像から生成した動画

パターン2画像から生成した動画

高画質の画像生成AIで作成した画像から生成した動画はさらにハイクオリティですね!

おすすめの最新画像生成AI FLUX+Runway Gen-3 Alpha Turboの組み合わせ是非試してみてください!

もしFLUXが使えない場合は、MIdjourney V6で高画質画像を生成しても良いでしょう。

料金プランと商用利用について

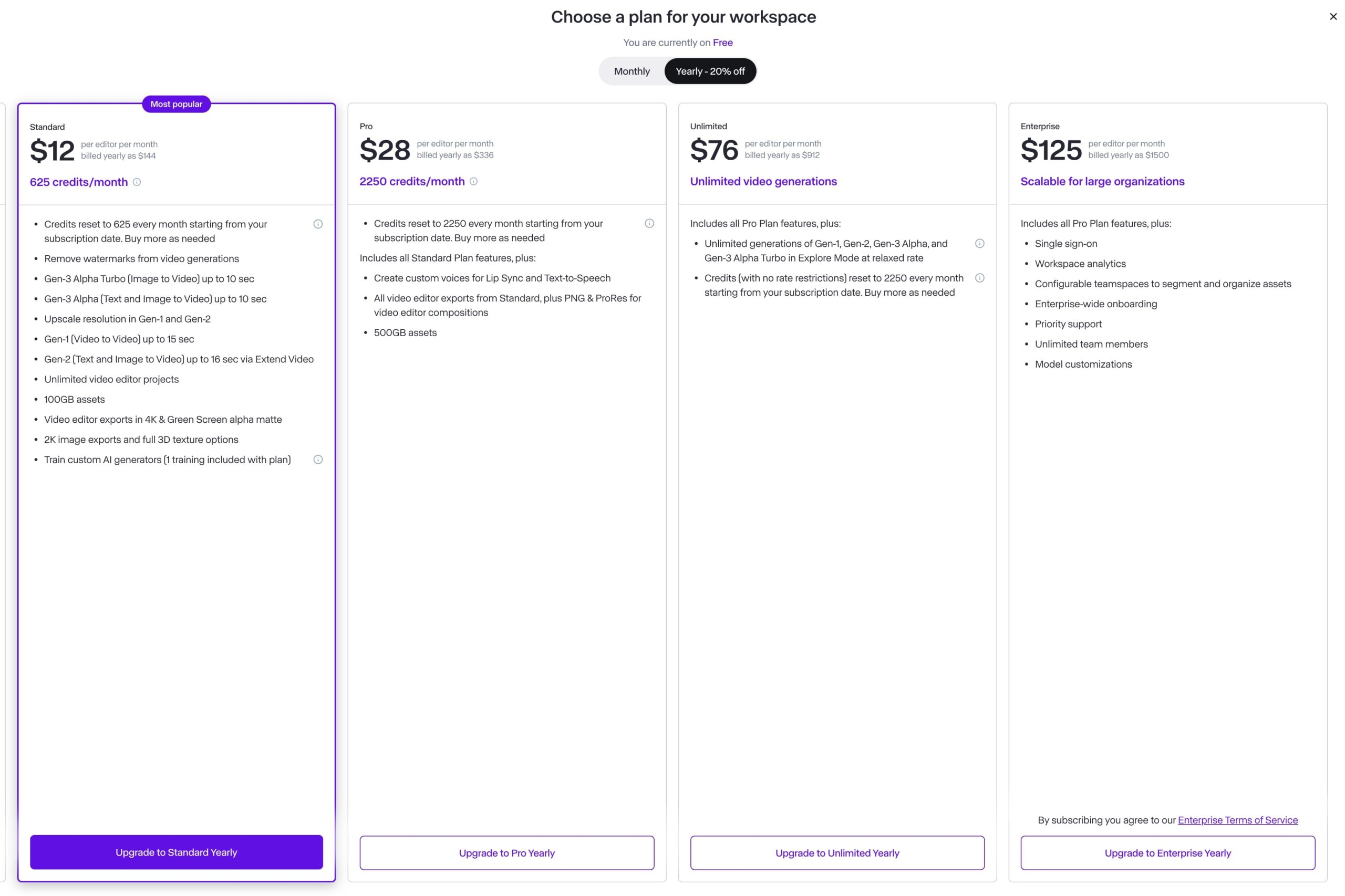

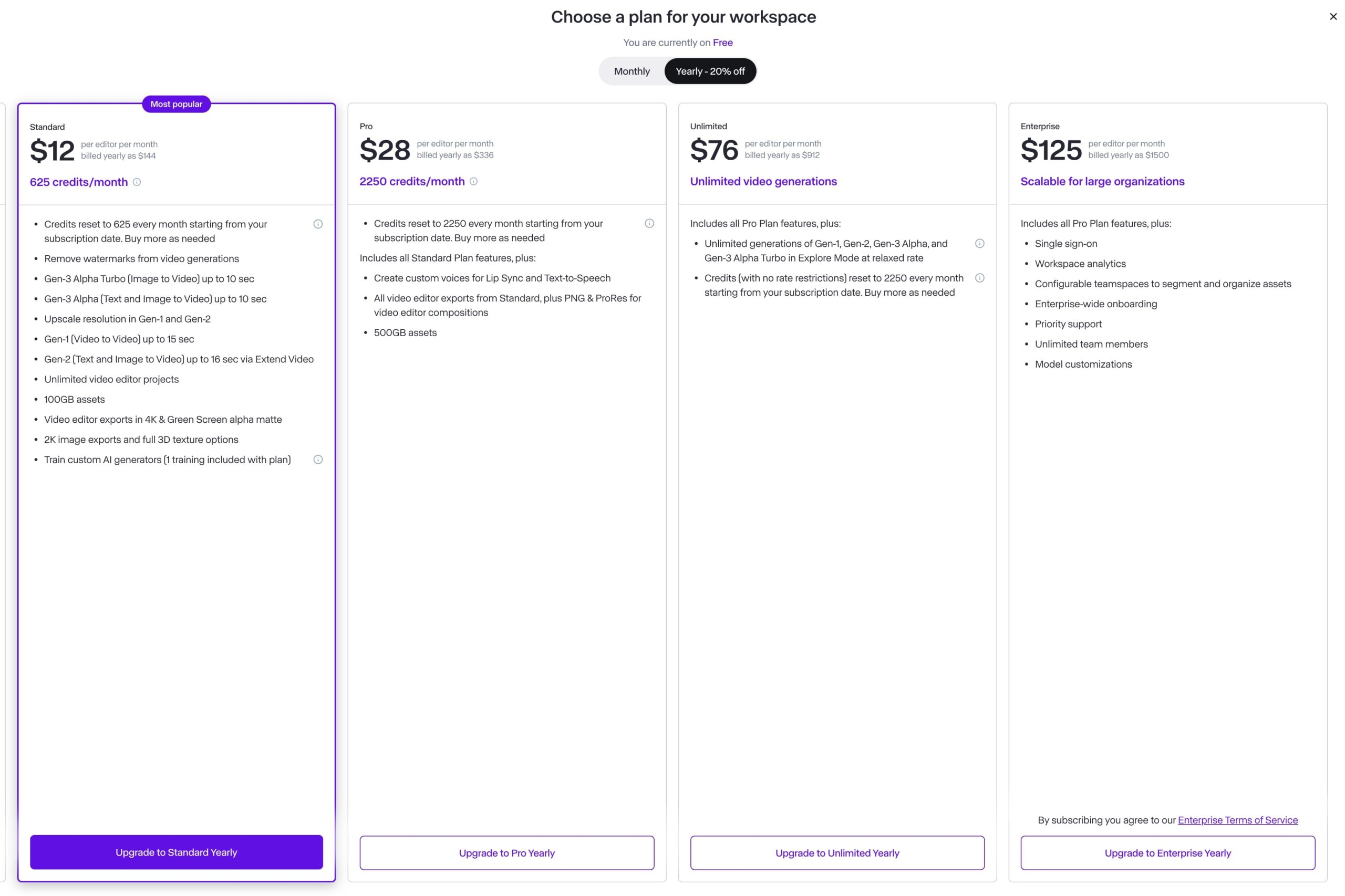

有料プランと無料プランの違い

Runwayの料金プランと無料プランとの主な違いを表にまとめました:

| 機能 | Basic (無料) | Standard ($12/月) | Pro ($28/月) | Unlimited ($95/月) |

|---|---|---|---|---|

| クレジット | 初回登録550クレジット限り | 625クレジット /月 | 2250クレジット/月 | 無制限 |

| Gen-3 Alpha | – | 最大10秒 | 最大10秒 | 最大10秒 |

| Gen-1/Gen-2解像度アップスケール | – | ○ | ○ | ○ |

| ウォーターマーク削除 | – | ○ | ○ | ○ |

| ビデオプロジェクト | 3つまで | 無制限 | 無制限 | 無制限 |

| ストレージ容量 | 5GB | 100GB | 500GB | カスタム |

| ビデオエクスポート | 720p | 4K | 4K | 4K |

| カスタムAIトレーニング | – | 1つ | 3つ | 無制限 |

商用利用できる?

Runwayの利用規約では、以下のようにコンテンツの著作権に関して記載しています。

・ユーザーが生成したコンテンツの著作権はユーザー側に帰属します。ユーザー生成したコンテンツに対して著作権を保持し、商用利用を含む自由な使用が可能

・ただし、Runwayhも生成されたコンテンツに対して一定の権利を有する

・Runwahはコンテンツの所有権は主張しない

・AIモデルの改善のために、ユーザーの入力と出力を使用する権利がある

・生成されたコンテンツに対して非独占的で広範囲な利用ライセンスを保持する

基本的にはユーザーがコンテンツの著作権を持ちますが、Runwayも一定の利用権を保持している点に注意が必要です。

具体的な利用方法や範囲については利用規約を詳細に確認することが重要です。

Runway 公式ページ 利用規約

引用元:Terms of Use Agreement

最新アップデート情報

2024年8月31日のアップデート

8月31日にXの投稿で40秒までの動画を生成できるようになったと発表されました。

Alpha Turboにはまだ実装されず、Gen-3 Alphaのみ対応です。

ただし、注意が必要なのは1回の生成で40秒の動画が生成されるのではありません。

1回のプロンプトでは、以前の通り5秒から10秒の動画の生成となり、これまでと違うのは続きの動画を生成できるようになりました。

生成した動画の左下に「Extend」(延長)ボタンがあるのでこのボタンを押すことで、続きの動画を生成することが出来、また1回1回のプロントでシーンを変えることもできます。

Extendができるのは、トータルで最大40秒までとなります。

最後に

この記事では、動画生成AI Runwayの最新アップデートGen-3 Alpha (Turbo)についてご紹介し、Runway Gen-3 Alpha Turboを使ってどのように画像やプロンプトから魅力的な動画を作成できるのかを実際に動画を生成して解説してきました。

Gen-3は、画質だけでなく一貫性や忠実性が格段に向上しました。

今後のアップデートでより詳細なアートディレクション機能を搭載する予定なのでより期待が高まります。

動画生成AIのレベルはここ1年だけでも目覚ましい進化を遂げています。

よりクリエイティブな活動な幅を広げ、ビジネスに活用されるチャンスも多くなっていくでしょう。

画像から動画を生成する楽しさを是非一度体験してみましょう!

当ブログでは、初心者からでもAIを学べるようAIについての知識の集約、解説、ChatGPTのおすすめスキルなどを発信して行きます。

よかったら、是非、ブックマーク&フォローしてください。

-

Perplexityのライバル登場?SearchGPTとは?SEOは終わるのか?

-

Perplexity AI 最新情報(新しいPage機能や最新A Iモデル)、安く使える裏技とは?

-

Claude 3.5 Sonnetとは?Claude最新情報、新機能「Artifacts(アーティファクト)」について徹底解説!

-

Outlook Copilotの全機能解説!ビジネス効率化を実現する使い方

-

DALL-E3がChatGPTに搭載!その魅力的な使用方法を探る

-

Teams Copilotは会議の最強アシスタント!活用することで月14時間の節約?